序編 プロローグ

ビジネスはすべてイノベーションとなってくる

7章 コア・プロダクツはサービス・ソフトウエアとなる

☆☆☆その2 ☆☆☆

4◇製品デザインフェーズのデータ分析

§4.1問題のタイプとデータ源

ここでは、データ分析の視点からプロダクツ・デザインのフェーズ3.を考える。

最初にこのフェーズの知識獲得とその形成活動を概観し、このフェーズ時有の問題の種類と、そこから生じるデータ取得法によるテータタイプを概観する。

◆ プロダクツ・デザインのためのプログラミング・フェーズ

このプロダクツ・デザインのプログラミング・フェーズは、ホール・プロダクツをデザインするという情報の獲得活動と、その蓄積と結果の形成の活動である。

このプログラミング・フェーズのテーマは、コア・プロダクツの完成と応用領域で用途と齟齬が無いようにホール・プロダクツとして仕上げること、また、それを前提としての用途にあった用法にとしてのユース・ウエアを実現でき、ソフトウエアとしてスケールアップできる仕組みの仕様をデザインすることと準備することである。

また、スケールアップに伴うモジュールやプロセスのインターフェース等の詳細設計仕様を固める連続的な試作と実装活動が中心となる。

試作を積み上げ、次々と現れる難関を、いわば”体験的集合知メカニズム”とでも言える活動の場で克服するため、自律的でフレキシブルに集団で開発作業を分担する必要があり、進展状況を刻々と誤らずチーム全体が共有するため、フレキシブルPERT法が利用される。

そして、プロジェクトのKPI関するデータと、各種仕様の確信と形式化の共有がなされる。

KPIに関するデザイン・レビューも、プロジェクト内の専門家が、βテストを受け持つが、この結果もプロジェクトの成果の進捗をティームが共有する必要がある.

そして、この時点で問題点を克服する度に、I.P.R.:知的財産権が多く得られる.

市場への参入準備のため、試作品を使った評価活動としてのデザイン・レビューなどへの配分スケジュールも重要となるが、設計仕様のバージョン管理としてのライブラリ管理と、評価データ分析も重要である。

同時に、開発方針としてのコアKPIが固まってくるので、開発者と独立した専門Gp.による冷静な計測データが採られ、マネジメントとチームメンバーの全てに共有され、各開発の専門Gp.は、自分達の技術仕様のバージョンが、各KIPに対し、どのような影響を与えたかを分析でき、共有できるようになる。

プロセス自体の開発が動き始めると、試作の流れとスタートアップが繋がり始め、データの量は大きくなるが、金型等の投資やパートナー達が立ち上がり始めると、仕様変更が難しくなり、リアルタイムの結果データからの知識獲得がメインとなる。

試作プロセスが動き始め、大きな変更を伴う実験は実行し難くなる半面、リアルタイムにデータが得られ蓄積され、改善的な活動がメインとなる。

リアルタイムに、大量の計量的特性と、各種の属性データが得られ、蓄積される。

プロセスの不具合をつぶし、周辺技術やカスタマー支援体制などを整えつつ、獲得されるデータを使ってKPIの改善のためのモデルを得て、プロダクツやプロセスの仕様を改善し詳細化して行く。

とはいえ、コア・アプリは、サービス・ニーズに基づく情況変更ニーズであり、イメージであり、“コトバ”でしか表現できない。

そのソリューションであるデザイン仕様は、数値や形状や材料やエネルギー等の形式知でしかデザインできない。こうした“コトバとデータ”の関係を、うまく処理する必要がある。

基本的には、プロダクツは、ユーザが実現したいサービス・ニーズを解決するプラット・フォームである。

そのプラット・フォームは、出来るだけ多様な情況に対し、出来るだけ多くのユーザに対し、できるだけ多様なサービスソリューションを提供する能力を持つ必要がある。

つまり、プラット・フォームとしての価値は、そうしたサービスのスコープの広さとユーザの厚みで決まるからである。

コア・アプリは、コア・プロダクツの使われ方、つまり新しい用途と用法でいわばユース・ウエアであり、その様相や様式はいわばソフトウエアやと言ったものであり、文化的な背景に支えられた善さや美しさと言ったイメージで語られるストーリでしか表現できない。

新しいプロダクツとして現れるフォームは、従来機能で説明できたが、そう言ったフォームは、いわばフィクションでしか表現できない。

つまり、新しいプロダクツやサービス・プラット・フォームを評価するデータには、いわばフィールドワークやリビングラボ等のデザイン・レビューで採取される”言葉のデータ”が重要となるのである。

とはいえ、コア・KPIは、F.O.M.として数量化されつつ、リファインされてくるが、基本的には言葉とその文脈に支えられた表相に過ぎない。

スケールアップするための基本的なプラット・フォームの能力としての基本KPIは、QCDを基本とするベイシック・KPIは、従来型の計量型計数型の数値変数タイプが多くなる。

また、教師データが利用できるので、多様な分析ツールを使うことができる。

また実験データではなく、過去データが多くなることもあるが、因果関係より、要因対効果の関係性のモデルが重要となる。

つまり、原因探索や責任追及よりも、対応法や対策の視点が、非常に重要となる。ここ点は、強調しすぎることは無いだろう。

◆ 問題タイプとデータ・タイプ

KPIは、開発目標であるコア・アプリに関するコア・KPIとホールプロダクツとしてのQCDに関する基本的・KPI群が基本体力でえありデザイン・レビューの基礎的評価尺度となる。

ベイシック・KPIとしては、ホール・プロダクツとしてのQ:品質、C:コスト、D:デリバリーの観点からその基礎的評価が決まる。これらがベイシック・KPIとなる。

ただし、スジが良く強いホール・プロダクツとなるためには、そのプロダクツのソフトウエアが働いたときに、関係するステーク・ホルダ、特にユーザの観点からのQCDがベイシック・KPIとされなくてはならない。

こうした基礎的な機能や性能を確り持ったコア・プロダクツは、ユーザと出合って使われたとき、ユースウエア―の能力を発揮できるようになる。

工場から出荷時の品質が良くても信頼性が悪ければ、ユーザの負担コストは大きくなる。註文して直ぐ手に入らなければ、顧客満足度は下がる。

ソフトであれば、最初にインストールしても、ある特定の使用条件で最初に期待したパフェ―マンスが得られなかったり、関連ソフトのバージョンアップで不具合が発生したりすることもある。

こうした主要なKPI群が固まって、それを左右する要因の構造が固まり材料や加工法や処理手順等の標準が実装され、供給工程や使われ始めたフィールドからデータが集まってくる。

大量に集積を始めたデータから、要因のパラメータ(水準)をどこにリファインしたら良いか、その許容差がデザイン仕様となる。

KPI群にはいろいろな特性の最大化、最少化、安定化等評価尺度もある。

それらの改善のためには、プロダクツがそのソフトウエアを発揮した時、どのような情況でどのようなパフォーマンスを発揮したかとい評価データ等と共に、大量に得られるようになる。

単にヒューリスティックなプロトタイプを試作するだけでなく、制限された状態のなかでも、要因間の交絡やノイズの管理や分離等の注意を払うことが重要である。またリビングラボでは、オーディエンスの段階的フォーカス的選択を図る必要がある。

さらに、将来この成功して後のコア技術の成長と、コア・ユーザの広がりとコア・ユースウエアの社会的進化を、プロスぺクティブについて言葉と数値等の形式値を伴ったシナリオで評価する必要があるだろう。

◆ 従来の方法の限界と挑戦

このフェーズで使われる従来のデータ分析法で代表的な手法を3上げるとすれば、

1)KPIを改善するためにその設計要因や製造要因との相関関係を調べる多重回帰分析、

2)また最近人気の多重回帰を拡張し、要因を組み合わせて新しい潜在要因とする潜在構造分析が挙げられる。

3)また、KPIや要因属性を質的な変数としてクロス集計表を造って分析するクロス集計法も、最近手軽な可視化ツールの発展もあり人気である。

ただ、これらの方法の限界や落とし穴について、注意が必要である。このフェーズでは、KPIの改善のためのモデルを得て、プロセスや仕様を改善したり、詳細化して行く、いわば正解のあるまた教師ありデータである。

しかし教師ありデータから説明モデルを得ようとする多くの方法は、ディープ・ラーニングやサポートベクタマシンを含め、同じトラップに落ち込んでしまう。

特に、教師ありデータの分析法の問題点は、独立変数間の構造を歪ませてしまうことに由来する。

こうした教師ありデータの分析では、多重回帰分析や潜在構造分析やディープ・ラーニング等が使われる。

回帰分析では、要因の特性値への効果を示すパラメータの値が、インフレーションを起こし、場合によると、符号まで逆になることがある。

これは、パラメータの推定にデータの逆行列を使うことに起因する。潜在構造分析は、それに加えて変数間の関係を付ける制約を付けるがそれにも同じ問題が入り込む。

それが根本的な問題点を持ち込むことになる。つまり、変数間の相関性に起因する根本的なモデルの脆弱性問題は避けられない。ただ、こうした過学習の問題は、教師ありデータ分析では、難しい。

最近は、不足する情報を補うため、変数を絞り込むL1正則やAIC等や、パラメータに制約条件を付けるL2正則や、不足情報を先験情報を追加するベイズ推定法等が研究されている

こうした考え方は、潜在構造分析でも研究が進むと期待される。

もう一つの良くある問題は、データが多くなると多重回帰分析や潜在構造分析やクロス集計データでは、”どんぶりデータの扱い”がつい多くなるが、要因対効果関係が逆にでる場合がある。

回帰分析では、混成母集団を対象とする多重回帰分析も逆の結論を導くことがある.

例えば年齢などで層別した場合と、全体をプールした場合で、回帰係数の符号が逆転することがある。これは母集団をどのように考えるかで、どちらも正しいと言える問題ではあるが意外ともいえる落とし穴でもある。

クロス集計表でも似たことがシンプソンのパラドックスとして知られている。これはいわば、変数間の交互作用によるいわゆるシンプソンのパラドックスと言われる逆の効果のモデルを得る危険がある.

この事例は、次節で少し詳しく説明しよう。

さらにもう一つ、多次元の要因に潜む落とし穴もある。これは、最近使われる単純なA/Bテストで改善して行く方法のような少ない要因で、KPIを逐次追い詰めて行く方法である。

いわゆる多次元の峠付近で起こすワンダリング現象と言われる。または簡単に実験ができ、やたらと刺激的で強い反応に導かれて、危険な尾根道をたどって引き返す途を失う現象である。

これには、要因の変化の範囲を広く動かすことが許されなくても、ボックス・ウイルソン型の逐次実験や田口の多因子諸水準型直交実験による誤差の圧縮法が有効で、リスクが少ない方法が有効である。

ただ、ハード・プロダクツの場合、生産工程が標準化され、コントロールされていれば、その環境条件の中では、動かす要因以外の全ての要因は統制されており、一定の安定した分布条件の誤差として大数の法則が効いて、その範囲では、安定した特性対要因効果のモデルが得られるだろう。

しかし、そのデータの分布の範囲外への推定に対しては、保証できない。

また、特性のバラツキを制御するため、母数要因と変量要因のミックスモデルのデータが多く、要因別分散成分の推定が複雑となる。そのため、特性のバラツキの要因分解と合成法も複雑で、こうしたニーズを満たすソフトも少ない。

この一般的モデルは、前の章で触れたが、詳細にはもう少し述べるべきであった。

コロナ問題で、日本からの貢献論文が少ないという指摘がある。クルーズ船の京都大の論文が1件だけ175の引用されただけだったのに対し、中国は延べ600を超え、フランスが600、米国も500以上であった。[2020年9月21、日経新聞]

もし、2、700人の行動ログデータとその80%の発症データが採られ、公開されていたら、世界の経済にも健康にも大きな貢献ができていたように思われる。

。

実は同日の新聞で日経は、「小児への医療被曝防げ」とした記事を載せて、小児の発生癌のリスクが40才までに比べ、5倍高いというデータを載せている。

福島のいわゆる低線量被爆によるリスクを、この地に住んでいる日本人の行動ログと診断データがリンクできれば、その変動要因別に分解でき、世界中の人々に対し、大きな貢献ができると思われる。

アポロプロジェクトを研究した井深は、その信頼性のデザイン・レビューを行うために必要だった予算をたづね、総予算のそれが1/3であったことを確認している。

デザイン・レビューは、データをとる活動である。ただそれには、費用と時間がかかる。まして、因果関係や分散成分を正確に分離するためには、要因の統制が必要であり、人体実験は許されない。

我が国は、貴重な機会を逃しつつある。

◆ 挑戦する連環データ分析のアプローチ

今まで、データ分析法は、扱う問題の構造別、扱うデータ構造やタイプ別に専門化が進んだ。結果として理論も抽象度が高くなり、ソフトも専門別に進化し細分化し、現場で使い難くなってきた。

昨今、セルフ・サービス・ビジネス・インテリジェンスが少し注目を浴びているが、なかなか使い易いデータ分析ソフトは少ない。

教師ありデータでは、従属変数への説明力を強くして説明変数の内部構造を壊していたが、双方を平等に扱いそれらの関係性を示す頑健なモデルが得られる可能性がある。

連環データ分析では、生のプロファイルデータを使いこうした関係性をコンセプト・コンパス・チャートから直接読み取るか、クラスター分析が可能となる。

独立変数間の構造を歪ませてまで、従属変数への説明力を強くせず、双方をレシプロカルに扱いそれらの関係性を示す頑健なモデルを得て、それをコンセプト・コンパス・チャートで可視化する。

連環データ分析では、従属変数への説明力を強くせず、双方をレシプロカルに扱いそれらの関係性を示す頑健なモデルを得て、それを例えば、”コンセプト・コンパス・チャート”として可視化する。

また、プーリングして逆転現象を起こす集計表のシンプソンのパラドックスは、個別のプロファイルデータを可視化するのが望ましく、連環データでは、それが分り易く理解できよう。

また、重回帰分析の問題でも、層別要因を追加アトリビュートとすることで、分りやすく表現できる。

計量変数となり易いKPIを改善する方向やそれに与える要因の意味の理解は、このフェーズでは、非常に大切である。

生のプロファイルデータを使った連環データ分析のコンセプト・コンパス・チャートでは、こうした関係性をチャートから直接読み取るか、クラスター分析とレスポンス曲面から読み取ることが可能となる。

コア・アプリのいわばコア・ソフトウエアの評価は、まだ発展途上である。

この種のデータは、リアルファクトについて、ヒトの眼耳鼻舌身意の6感に写像され、再生されることが期待されつつも、捨象されて記録された表現体としてのファクトデータとなる。

現在の状態と新しい状態とは、ヒトが感知できるファクトデータで記録された意味のあるデータとして表現された情報でなくてはならず、イノベーションもまたそれらをつなぐ役に立つアーク(橋)として、不確実性を低減でき広く使える獲得された知識としての情報でなくてはならない。

・ワードやデータ技術の援用

このフェーズでは、KPI群が固まり、その意味を全員が判って共有できるようになる。

改善のためのモデルを得て、プロセスや仕様を改善したり、詳細化して行く、いわば正解のあるまた教師ありデータが溢れだすフェーズである。

しかし教師ありデータから説明モデルを得ようとする多くの方法は、ディープラーニングやサポートベクタマシンを含め、同じトラップに落ち込んでしまう

§4.2多重回帰分析とその限界

◆ 多重回帰分析の機能

ある関心の特性値を何か他の属性値で説明したり、他の属性値から特性値を推定したい場合が、多い。

統計的分析法の中で、最も使われるのは、こうした形で得られたデータから、役にたつ知識となるデータモデルを得ることで、各種あるデータ分析法の中で、良く使われるものの一つが回帰分析である。

回帰分析では、関心の対象体の特性値は、目的変数や従属変数と呼ばれ、対象体が持つ属性の属性値は説明変数や独立変数や要因の取る値等と呼ばれる。

説明変数が一つの場合は単回帰分析と呼ばれ、説明変数が複数ある場合は、手変量回帰分析や多重回帰分析と呼ばれる。

目的変数は、多くの場合連続的な計量値であるが、説明変数も計量値であるが、計数値でも良い。

多変量回帰分析の目的は、特性値に影響を与える要因が複数あるとき、それらの要因の値が特性値にあたえる影響度を知ることである。

例えば、あるコンビニのスイーツの商品のある月の売上を目的変数Yとし、その説明変数を、価格X1と含まれる糖分X2と大きさX3とすると、説明変数が3種の多変量回帰分析となる。

例えば、ブラウン管の明るさを目的変数Yとし、ブラウン管の光る蛍光面の電圧X1と、電子銃と蛍光面までの距離X2を説明変数とすると説明変数が2の多変量回帰分析問題となる。

◆大数の法則

[図7.4.1: 多変量回帰分析の働き(1/6)]

ランダムにトライした結果の平均値は、トライアルの数を増やすと真の値に近づく。例えば、サイコロを振って1の目の出たら1としそうでなかったら0としてその合計をトライした回数で割った平均値は1/6に近づく。

例えば、ヒトの知識でも、大勢の意見を集めると、真の値に近づくという現象があり、それが実現するためのメカニズムの研究が進んでいる。

これも1種の大数の法則が働いていると言われている。

集合知は、大西洋で行方不明となった原潜スコーピオン号の探索等で有名となったが、集合知が働く原理の一つは大数の法則であると言われている.

IBMは2006年夏、「Innovation(革新)をテーマにIBMが世界にどのように貢献できるか」というテーマの下、大規模オンライン・ディスカッションを開催した.これは104カ国の社員と家族、顧客企業、計15万人以上を対象にした、集合知メカニズムによる知識創造イベントで、3万7,000件のアイデアが出され、最終的に10のアイデアに絞られ、今後2年間で1億ドルの投資を行うことが決定された.

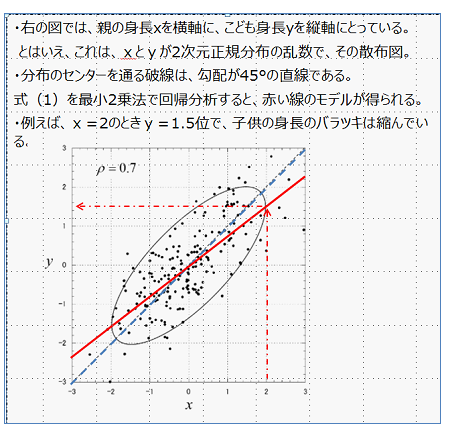

◆ 最小2乗法と回帰分析

ガウスがとラプラスは、19世紀初頭、ランダムに採られたデータの平均値が母平均に近づくという大数の法則と、データの平均値は正規分布に近づくという中心極限定理を発見し、最小二乗法を発明した.これはある特性値に対し、どのような要因がどのような影響を与えるかという数式規準モデルを、データから得る方法である.

[図7.4.2: 多変量回帰分析の働き(2/6)]

このデータを回帰分析して、Y=bXという規準モデルが得られたとすると、親の身長からその子の身長が推定できる。

[図7.4.3: 多変量回帰分析の働き(3/6)]

しかし、もし子供の身長からその親の身長を推定したいときは、この基準モデルは使わない方が良い。つまり、この式を変換して、X=1/b*Yでは、推定誤差は大きくなってしまう。

よく、回帰分析は因果関係を知るためという説明があるが、気をつける必要がある。

(ただ、このデータは、回帰分析をし易いように、元データを正規化してある。つまり元データからそれぞれの平均値を引き、それぞれに標準偏差で割ってある。)

確かに子どもは親から生まれたので、それは因果関係とも言えるかも知れないが、通販サイトで子ども服を買ったデータから、親のサイズを推定するのには、因果関係ではない。

規準モデルをX=cYと作り変え、評価モデルも変えて計算し直した方が良い。c=1/bとはならないにである。

回帰分析モデルは、あくまで目的変数を説明変数で説明や推定をするモデルである。

回帰分析は、データに基づく技術の最も良く使われる方法であるが、3段階のモデルが仮定されている。

まず「規準モデル」として、要因の効果が独立で線形モデル(要因の効果に加法性が成り立つとする)であり、特性値に独立な誤差が含まれることを前提にしている。

次に、「評価モデル」として、特性値の推定誤差の2乗和を最小にしたいという前提に立っている。ここでは、特性値と効果の組合せの規準モデルとのズレを、線形ではなく2次形式というを2乗の関係で評価している。

最後に、「導出モデル」として、線形連立モデルを解く形となっている.

◆データセット

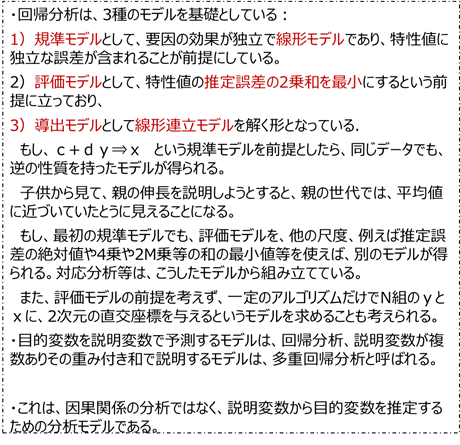

多変量回帰分析では、幾つかの観測データのセット(集合)を扱う。

目的変数をY、説明変数をXとし、目的変数となるN個の特性と、その特性の説明変数となるM個の属性が採取できたとする。これをエクセル等でクロス表形式で(7.1)のように整理する。

[図7.4.4: 多変量回帰分析の働き(4/6)]

観測データは、N行M列の行列の形となる。

これから、式(7.2)のように表現するモデルを得るのが目的である。

◆多重回帰分析の計算法

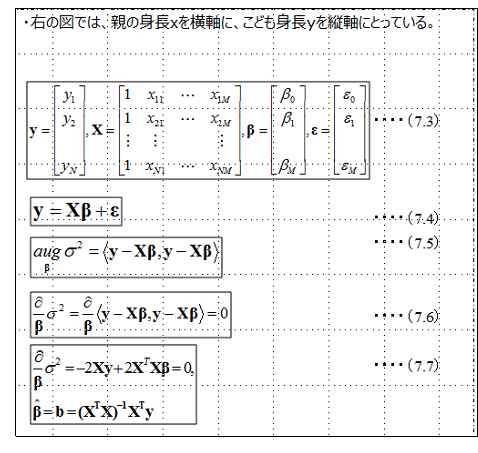

[図7.4.5: 多変量回帰分析の働き(5/6)]

これを行列やベクトルで、(7.3)や(7.4)と簡潔に規準モデルが表現できる。

つまり、長さN次元の目的変数ベクトルyは、N行M列の説明変数マトリックスXと、長さM次元の係数(重み)ベクトルβとの積と、長さN次元の誤差ベクトルεの和になっている。

次に、評価モデルは、(7.5)で、これは、誤差ベクトルεの内積となっている。

最適な係数ベクトルβを求めるためにはσ^2をβで偏微分してゼロになる連立方程式をたてると(7.6)の導出モデルが得られる。これを解くとσ^2を最小にするβが解析的に求まることになる。

◆多変量回帰分析の機能と利用範囲

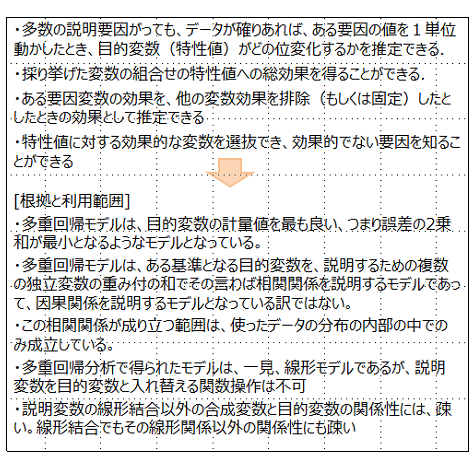

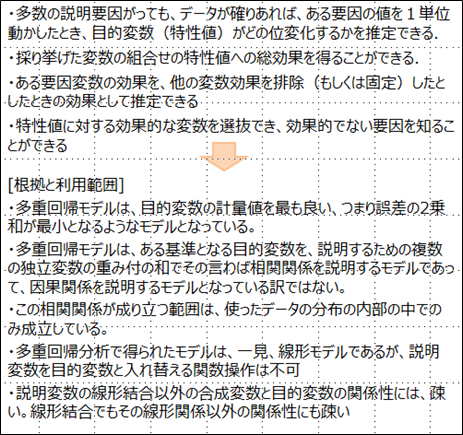

まとめると多変量回帰分析モデルは、つぎのような働きをする。

1)多数の説明要因がっても、データが確りあれば、ある要因の値を1単位動かしたとき、目的変数(特性値)がどの位変化するかを推定できる.

2)ある要因変数の効果を、他の変数効果を排除した独立な効果が推定できる.

3)採り挙げた変数の組合せの特性値への総効果を得ることができる.

4)特性値に対する効果的な変数を選抜でき、効果的でない要因を知ることができる

多変量回帰モデルは、目的変数の計量値を最も説明の精度が高い、つまり誤差の2乗和が最小となるようなモデルとなっている。

とはいえ、多変量回帰モデルは、ある基準となる目的変数を、説明するための複数の変数の重み付の和でその言わば相関関係を説明するモデルであって、因果関係を説明するモデルとなっている訳ではない。

[図7.4.6: 多変量回帰分析の働き(6/6)]

また、この相関関係が成り立つ範囲は、使ったデータの分布の内部の中でのみ成立している。もし、使ったデータの分布の外側のケース(厳密には多次元分布の外側)に適用する場合は、その説明精度は、極めて怪しくなる。

多重回帰分析で得られたモデルは、一見、線形モデルであるが、説明変数を目的変数と入れ替える関数操作は不可である。特に、何本かのモデルを得てこれらを組み合わせて新しいモデルを得ようとする場合は、気を付ける必要がある。

説明変数の線形結合変数を使う場合は、次のセクションで説明する共線性の問題が混入してくるので、注意が必要である。また、非線形の結合変数を入れる場合は、その意味と構造について吟味が必要である。

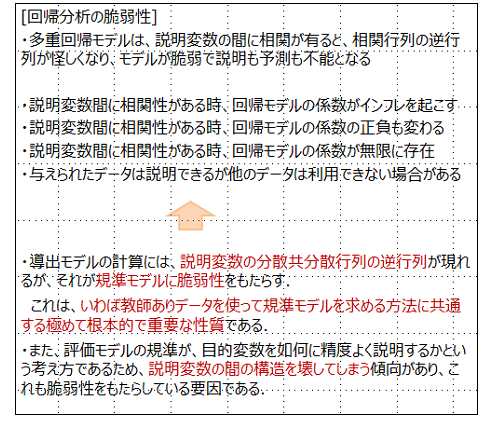

◆ 多変量回帰分析の脆弱性

しかし、回帰分析には、基本的な脆弱性がある。

それについて、忘れもしないあるトピックスを思い出す。

1960年代、IBMが磁気記録技術をソニーから導入し、ある特性を改良して、データベース用のマスターテープの開発を試みたことがあった.まだ、メインフレーム・コンピュータの外部記憶装置として大型ディスクが登場する以前の話である。

データベースのテープから、転写して子ども世代のテープを造るため、データベースとなるテープの保持力の高いテープを開発する目標が建てられた。

これを目的変数とし、テープの大量生産工程の温度や処理時間やバインダ等の120の製造要因を説明変数として、回帰分析で、製造プロセスの仕様をデザインしようとしたのである。

立ち上げられた製造プロセスの揺れのデータを大量に集積しつつ、前進後退型の多重回帰分析を行いつつ、工程条件を最適と思われる方向に、少しづつ製造中心のキャンプ位置を移動させて行った.

しかし突然、この大型投資をした工程が乱れ、工場が不良品テープの大量生産工場となってしまったのである.結果、ソニーから駆け付けた7人のエンジニア達が機械の隣りに寝袋で泊まり込んで正常な工程状態を取り戻したことがあった.

多重回帰モデルは、リスクが高い.これは、正解がある教師ありデータの分析法のほとんどが持つ脆弱性である

◆ 多重共線性という問題

こうした多変量回帰分析における脆弱性の問題は、説明変数間に相関があるとき、発生する。

[図7.4.8:多重回帰分析の限界と注意点(2/3)]

これらは、いわゆる共線性とか多重相関性とか呼ばれる問題である。説明変数を独立変数と呼ぶが、多少の危うさがある。

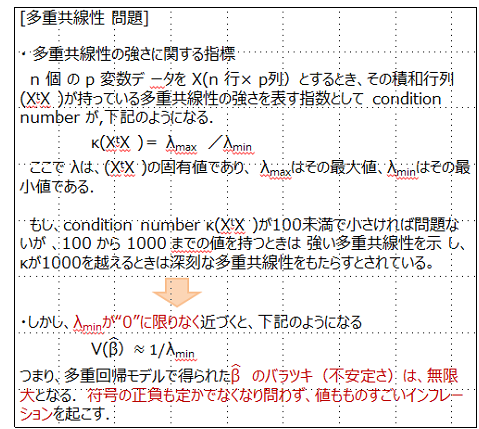

この多重共線性の強さに関しては、指標がある。

n 個 の p 変数デ ータを X(n 行× p列)とするとき、その積和行列 (XtX )が持っている多重共線性の強さを表す指数として condition number は,

κ(XtX )= λmax /λmin

のように示される.XtはXの天地行列である。

ここで λは、(XtX )の固有値であり、 λmaxはその最大値、λminはその最小値である.

もし、condition number κ(XtX )が100未満で小さければ問題ないが 、100 から 1000 までの値を持つときは 強い多重共線性を示 し、κが1000を越えるときは深刻な多重共線性をもたらすとされている。

[図7.4.8]

しかし、λminが“0”に限りなく近づくと、

V(β)≈1/λmin

となる.つまり、多変量回帰モデルで得られたβ のバラツキ(不安定さ)は、無限大となる.符号の正負は問わず、値もものすごいインフレーションを起こす.

これが、IBMのケースだけでなく、多くの実際の現場で誤った結論を導いた原因である。

つまり、導出モデルの計算には、説明変数の分散共分散行列の逆行列が現れるが、それが規準モデルに脆弱性をもたらす.

[図7.4.9:多重回帰分析の限界と注意点(3/3)]

こうした多変量回帰分析における脆弱性の問題は、説明変数間に相関があるとき、発生する。その結果、多重回帰分析の弱点として

・説明変数間に相関性がある時、回帰モデルの係数がインフレを起こす

・説明変数間に相関性がある時、回帰モデルの係数の正負も変わる

・説明変数間に相関性がある時、回帰モデルの係数が無限に存在

・与えられたデータは説明できるが他のデータは利用できない場合がある

これは、いわば教師ありデータを使って規準モデルを求める方法に共通する極めて重要な問題である.

この基本には、評価モデルの規準が、目的変数を如何に精度よく説明するかという考え方であるため、説明変数の間の構造を壊してしまう傾向があり、これも脆弱性をもたらしている要因である.

◆多変量回帰分析の脆弱性を回避する挑戦

多変量回帰分析のこうした欠点にも関わらず、通常のビジネスプロセスから生成されるデータから、有用な知識が得られる多変量回帰分析の威力は、大きく、また魅力も大きい。

ソニーのトリニトロンの絶対優位をかち取ったエピソードや、2002年にソニーを襲ったショックを救ったのも、多変量回帰分析のこうした脆弱性をカバーした方法であった。

この本のエピローグで披露したい。

多変量回帰分析の脆弱性をカバーする方法は、1971年に発表されたRidge regression に関する2本の論文であった。これは、回帰係数βのインフレを制御する方式の一つで、次に説明するいわゆる現在はL2正則法と呼ばれる方法であった。

以下、こうした方法を見てみよう。

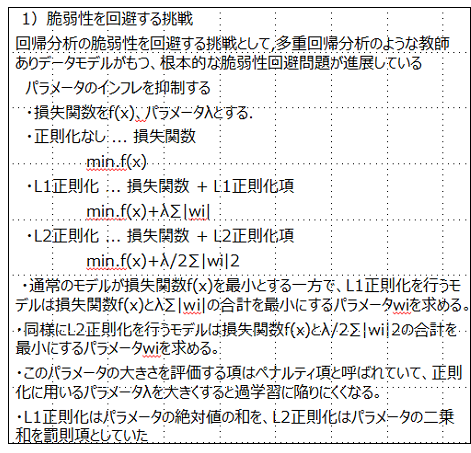

◆ パラメータのインフレを抑制する方法

評価モデルとしての損失関数をf(x)、パラメータλとする。

・通常の正則化なしでは、 損失関数とその最少化は、

min.f(x)

としている。

・L1正則化では、 通常の損失関数にL1正則化項を加えてこの最小化を

min.f(x)+λ∑|wi|

としている。

通常のモデルが損失関数f(x)を最小とする一方で、L1正則化を行うモデルは損失関数f(x)とλ∑|wi|の合計を最小にするパラメータλ、wiを求める。

・L2正則化では、通常の損失関数にL2正則化項を加えてこの最小化を

min.f(x)+λ/2∑|wi|2

としている。

同様にL2正則化を行うモデルは損失関数f(x)とλ/2∑|wi|2の合計を最小にするパラメータλ、wiを求める。

[図7.4.10: 回帰分析の進展(1/2)]

L1正則化はパラメータの絶対値の和を、L2正則化はパラメータの二乗和を罰則項としている。これらの数式から正則化はパラメータが小さいモデルをより評価すると分かる。

このパラメータの大きさを評価する項はペナルティ項と呼ばれ、正則化に用いるパラメータλを大きくすると過学習に陥りにくくならないようになっている。

この様な正則化法の欠点は、いわばブレーキ役のペナルティ項とアクセル役のβとのせめぎ合いが、微妙で、「科学的根拠が得られない」ということであった。ただ、ビッグデータ時代の実務的で技術的な有用性から、注目を浴びつつあるというのが現実である。

科学的でなくても、技術的に進歩性があれば、応用統計学として使われる。

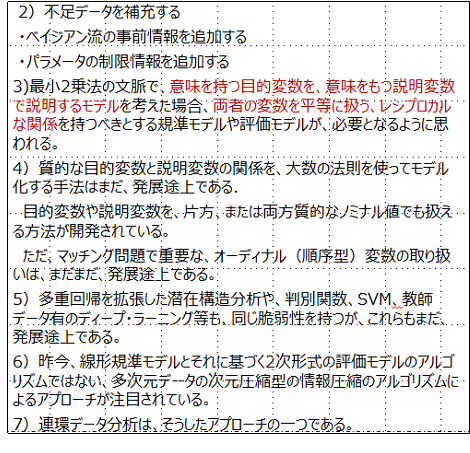

◆ その他のアプローチ

多変量回帰分析の脆弱性を回避する挑戦として、回帰係数のインフレーションを言わば力ずくで抑える方法の他に、いろいろな方法が開発されつつある。

その多くが、独立したパラメータを推定するに必要な情報量の不足に起因するもので、それを補充する考え方である。

その一つに、ベイジアン流の事前情報を追加するアプローチがある。それは、βの事前確率で補ったり、主観的な情報で補完する方法で、実はこれは、L2正則に近い。また、ヒトの認知のイメージの補完作用とも関係しているようでもある。

[図7.4.11: 回帰分析の進展(2/2)]

もう一つの方向は、パラメータの制限情報を追加することで、パラメータβの存在空間に制限を加えるアプローチである。

これは、L1正則に近いアプローチでもある。

また、これも、人知の先験的な事前情報を利用する方向でもある。

これらのいずれのアプローチも、ヒトの集合知メカニズムを利用する方法として、進化が期待される。

ただ、全くことなったアプローチも進化しつつある。

最小2乗法の文脈で、意味を持つ目的変数を、意味をもつ説明変数で説明するモデルを考えた場合、両者の変数を平等に扱う、レシプロカルな関係を持つべきとする規準モデルや評価モデルが、必要となるように思われる。

また、質的なデータとして、ノミナルな変数は、マーケティングや、医療などでも認知症や、高齢によるフレイル症等の属性値としては、重要性の認識が広まっている。

今回のコロナ対応でも、陽性かどうかの判定をするのに、高体温の有無や、特定の地域からかどうか、濃密接触者かどうか等[0か1]で判定されるノミナル変数は、もっと増やして精度を上げて行かなくてはならない。

さらに重要となるのは、オーデナルな順序変量となるかも知れない。例えば、トリアージと言うわれる、集中治療室への治療等の優先順位付け等だけでなく、希望する教育や就職先の選択や、イノベ―ションへの潜在資源の割り付けに至るまで、その役割が増すように思われる。

この領域は、まだ発展途上ではなかろうか?

昨今、2次形式の評価モデルのアルゴリズムだけではない、多次元データの次元圧縮型の情報圧縮のアルゴリズムによるアプローチが注目されている。

連環データ分析も、そうした領域の近辺で、発展してきた分析法である。これらについては、続編で触れたい。

§4.3◆潜在構想分析の働きとその限界

◆最近因果関係への執着が見られるが

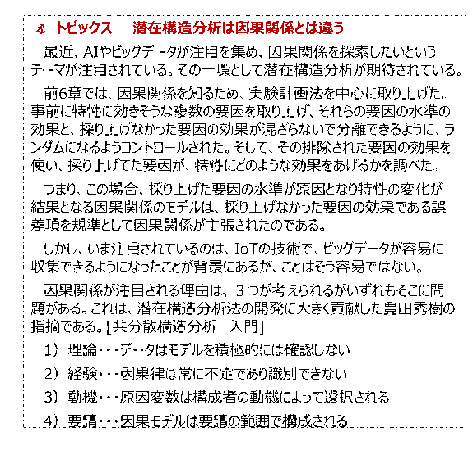

昨今必要以上に因果関係への執着が見られるように思われる。AIやビッグデータが注目を集め、因果関係を探索したいというテーマが注目されている。その一環として潜在構造分析が期待されている。

この直前の6章では、因果関係を知るため、実験計画法を中心に取り上げた。事前に特性に効きそうな複数の要因を取り上げ、それらの要因の水準の効果と、採り上げなかった要因の効果が混ざらないで分離できるように、ランダムになるようコントロール、統制が採られた。そして、その排除された要因の効果を使い、採り上げてた要因が、特性にどのような効果をあげるかを調べた。

つまり、この場合、採り上げた要因の水準が原因となり特性の変化が結果となる因果関係のモデルは、採り上げなかった要因の効果を分離してその誤差項を規準として因果関係が主張されたのである。

しかし、いま注目されているのは、IoTの技術で、ビッグデータが容易に収集できるようになったことが背景にあるが、ことはそう容易ではない。

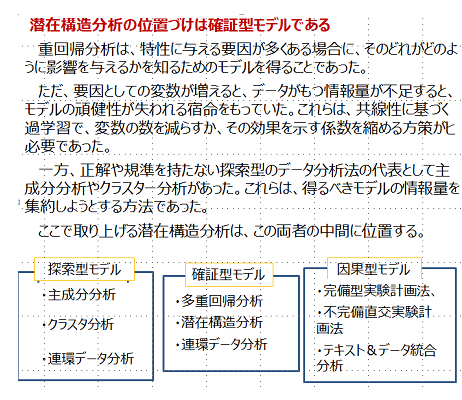

ここでは、改めてデータ分析や多変量データ分析、あるいは多次元データ分析の分類から、潜在構造分析をデータ分析のタイプからその位置づけを整理してみたい。

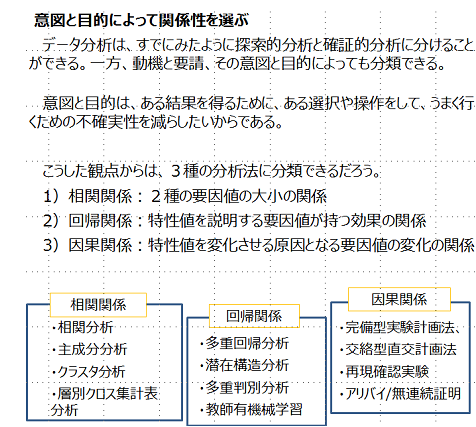

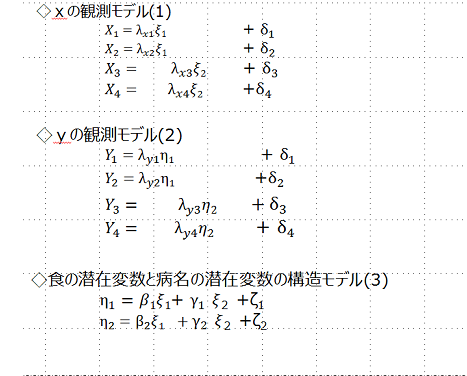

◆多次元データ分析の分類

[図7.4.12]

一般にデータ分析は、「探索型分析モデル」と「確証型分析モデル」に分類される。探索型分析とは、複雑なデータを整理・要約し、同時に要約しきれない特異なパターンを抽出する。確証型分析は、あるある仮説を検証しようとする。[鷲尾㤗俊、他、多次元データの解析]

また、ここまで取り上げてきた多変量データ分析は、互いに従属な統計解析であるとして、「従属関係:dependence」を扱うか、「相互従属関係:interdependence」を扱うかの2種類に分けることができるとしている。[M.G. ケンドール]

しかし最近は、潜在構造分析と言われるデータ分析法への期待に繋がっているように思われる。

因果関係への過大ともいえる期待が見られる。それが、潜在構造分析やここでは触れないが、ベイジアンネットワーク分析や、外生変数に非正規分布の仮定を置くセミパラメトリックな統計的因果関係推論:causal inference等も注目されている。[清水昌平、統計的因果関係探索]

ここでは、敢えて因果型分析モデルを探索型や確証型から分離した。それは、確証型分析から因果型分析へのアプローチが近年盛んになってきたので、その差異に気を付ける必要があると感じたからである。

探索型モデルで典型的な分析には、「主成分分析」や「クラスタ分析」、そして「連環データ分析」等がある。

これらは、”複雑なデータを整理・要約し、同時に要約しきれない特異なパターンを抽出する方法”群であり、多変数の間の「相互従属関係」を扱っている。また、”明らかに因果関係”は扱っていない。つまりこれらは、ある変数に対し「従属関係」に関する前提や仮説を持っていない。

これらは、正解や規準を持たない探索型のデータ分析法の代表で、得るべきモデルの情報量を集約しようとする方法である。売上6兆円のウオールマートは、顧客を購買行動等の膨大ないわゆるビッグデータを、1000個位のクラスターに分けてモニタリングしていると言われる。10の9乗バイト以上のデータを、1000に分類しているとすれば、10ビットに集約して管理していると言える。

確証型モデルで典型的な分析には、「多重回帰分析」、「潜在構造分析」、「連環データ分析」等がある。

これらは、”ある仮説を検証”しようとしているとみることができ、「従属関係」を扱っている。「多重回帰分析」は、目的変数を他の変数に重みづけした変数で説明できるという仮説に立ったモデルである。もちろんこれは、説明力がデータに照らして弱ければ、否定される。

「潜在構造分析」は、必ずしも目的変数が明確になったモデルばかりではないが、いろいろな変数が他の変数を説明できるとし、変数間に説明できるとする方向性が仮説として取り込まれている。とはいえ、だからと言って、原因と結果の関係を説明できるモデルとは言えない。

「連環データ分析」はいろいろな用法があるが、ある個別なサブジェク・トアイテムとそのある属性としてのアトリビュート変数のクラスター状に分布する関係性に対し、他のアトリビュート変数との関係で説明したいとする場合は、確証的で、また回帰的分析でとなる。

例えば、ある購買行動をした顧客が、従来の購買行動クラスターのどこに属するかを推定したい等の問題である。

重回帰分析は、特性に与える要因が多くある場合に、そのどれがどのようにどの位の影響を与えるかを知るためのモデルを得ることであった。

ただ、要因としての変数が増えると、データがもつ情報量が不足し、モデルの頑健性が失われる宿命をもっていた。これらは、共線性に基づく過学習で、変数の数を減らすか、その効果を示す係数を縮める方策がヒ必要であった。

潜在構造分析でも、変数を集約するためにより抽象的な変数を主観的に導入する方法としても見ることができるが、方向性を持った方法のこの基本的脆弱性の問題から逃げる訳にはいかない。

因果型モデルで典型的な分析には、「完備型実験計画法」や「不完備直交実験計画法」、そして「連環データ分析によるテキスト&データ統合分析」等がある。こうした原因結果関係は、相関関係だけでなく、時間的順序関係が必要となる。

また、ある事象Aがある時ある事象Bが起き、事象Aが起きないとき事象Bも起きないとする確認も必要である。つまり事象Aの生起や不生起に関し操作が可能でないとこのモデルの検証は難しい。

加えて、有る事象Aを生起させたとき、別の事象Cが生起し、実は事象Bの原因が事象Cである場合があり得る。つまり事象Aと事象C(事象A以外の)との関係が切られた場合、Bの原因はCだけとなる。つまりこうした要因間の関係を確りコントロールした実験が必要である。

こうした良く統制された環境において、取り上げた要因の水準(条件レベル)の全ての組合せを計画し、ランダムに実験し分析する「完備型実験計画法」や、多要因で少水準型の「部分交絡法の不完備直交実験計画法」が用いられる。

ただ、この場合でも、実験計画した範囲から外側に対しての因果関係の保証は無い。

因果関係が注目されるが、それについて4つの視点が考えられるがいずれも問題がある。これは、潜在構造分析法の開発に大きく貢献した豊田秀樹の指摘である。[共分散構造分析 入門]

1)理論・・・データはモデルを積極的には確認しない

2)経験・・・因果律は常に不定であり識別できない

3)動機・・・原因変数は構成者の動機によって選択される

4)要請・・・因果モデルは要請の範囲で構成される

ここでは、因果関係の分析は、実験ができないフィールドでは、非常に限定的となるという理由が明確に述べられている。

また、たとえ実験ができたとしても、そうしたデータ機能法に基づく限りは、得られる知識を利用する範囲に気を付ける必要があるということでもある。

[図7.4.13]

「連環データ分析によるワード&データ統合マイニング」は、少ないプロトタイプのリビングラボでも、因果関係に関係する知識を得ることが可能となる場合がある。このケースは、続編で紹介する。

さて、分析する動機や要請を明確にすること、つまり意図や目的を明確に意識する必要がある。

◆潜在構造分析の位置づけを試みる

こうした問題に取り組むとき、もう一度潜在構造分析というデータ分析の役割を見ておきたい。

潜在構造分析は、相関分析と因果関係分析の両者の中間に位置するように理解できる。

[図7.4.14]

一般の相関分析は、2変量のそれも計量値や計数値や順序値等のデータに限られるデータ分析法である。

それは、従属関係ではなく、相互従属関係を扱っている。これは、主成分分析、クラスター分析、あるいは層別や要因別クロス集計表分析でも同じである。つまり、全ての変数は、平等に扱われている。

この対極にあるのが、因果関係分析である。それは、完全原因と結果という言わば絶対の従属関係である。これには、再現確認実験やアリバイ(不在)証明で原因でないことを説明することや、連続性が保証された事象での断絶証明もそうした仲間に入れてもよいかも知れない。

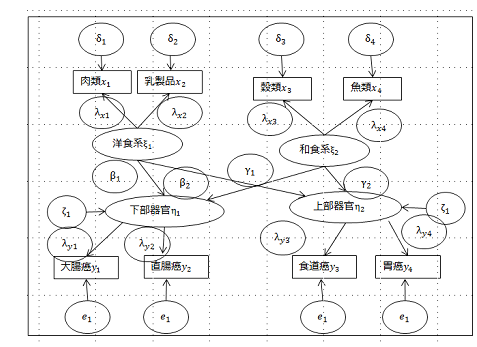

◆ 食事と病の回帰的関係を潜在構造分析で理解する

具体的な問題を見ておこう。

食事と健康の関係は、人類の智慧によって長らく言い伝えられ、文化として引き継がれてきたものであろう。

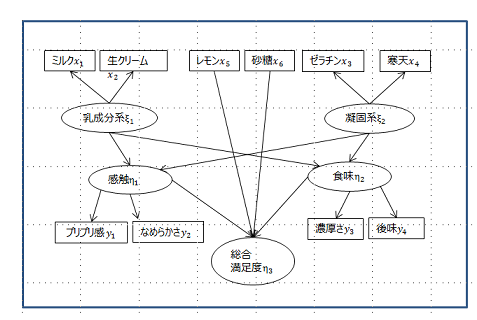

ちょっとややこしいが、因果関係は、図の上から下に向って流れるように配置されている。

上部に食事の種類があり、下部にガン疾患の種類がある。

食事は、”肉類”、”乳製品”、”穀類”、と”魚類”の4種である。これらは、楕円に最初の2種が”洋食系”とカテゴリーに集約され、後者の2種は、”和食系”のカテゴリーにまとめられている。

また、疾患も4種類があるが、”大腸癌”と”直腸癌”は”下部器官”に、”食道癌”と”胃癌”は”上部器官”のカテゴリーに集約されている。

そして、抽象的も集約された原因系の”洋食系”と”和食系”が結果系の”下部器官”と”上部器官”の結果系に対しどのような関係性を持っているかのいわば、回帰関係を構成している。こうした回帰関係は、矢印で表現されている。

[図7.4.15 パス図]

四角で表現された変数は、観測される外生変数である。この外生変数は、誤差項としての円で表現された変数を伴っている。

楕円で表現された変数は、主観的に仮説的に設定された変数で、内部的に生成される内生変数と呼ばれる。

また、小さな丸で示され、どこからも矢印が刺さっていないのは誤差項であるが、それらは向かった先の変数に関する誤差ではなく、その変数を説明している変数では説明できていない他の要因や線形の相関関係で説明できなかった近似のズレを表している。また、変数間の間の丸で示されたのは、変数間の相関係数である。

この様な内生変数や観測された変数の相関関係や回帰関係を示した図は、パス図と呼ばれる。

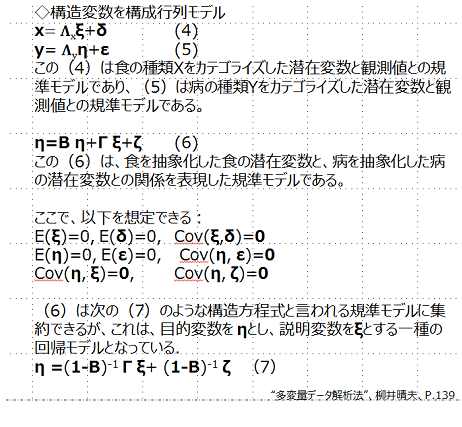

こうして、食に関する観測値と主観的潜在変数の回帰関係モデルは、式(1)、病名に関する観測値と潜在変数の回帰関係モデルは(2)のように表現される。

また、食と病に関する潜在変数の回帰関係モデルは、式(3)の様に表現される。

そして、観察変数に対しる潜在変数の回帰関係モデルは、それぞれ式(4)、(5)の様に表現される。

また、式(6)は、食を抽象化した潜在変数と、病をちゅ消化した潜在変数の回帰関係を表現している。そして、これらの変数や誤差の期待値や共分散の仮定を表現している。

さらに、式(7)は、これらを構造方程式として統合した回帰モデルの表現である。

いわばこれらが、規準モデルである。

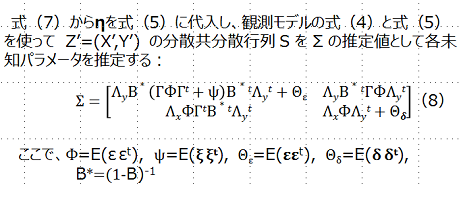

◆ 導出モデル

この構造方程式を規準モデルとしたとき、未知のパラメータを決める必要があるが、その計算法の基礎となる導出モデルは、どうであろうか?

ただ、ここでも(1-B)-1が現れる。当然これは、重回帰分析でもモデルの脆弱性をもたらした構造である。

多重回帰で取り上げた変数を全て使い、かつ潜在変数を追加するから、推定すべき未知パラメータの数は増大している。観測データがおなじであれば、上手に潜在変数で集約できていないと、脆弱性はむしろ増大する危険がある。

そこで、この潜在構造分析は、(7)式の構造方程式を実際の経験的知見と得られたデータの持つ力を上手く組み合わせるいわば探索過程が必要となる。

潜在構造分析のアルゴリズムは、未知母数を含むΣをSから推定できるとし、その幾つかの連立方程式群を解くことに帰着する。

評価モデルは、未知母数を含むΣを、観測データのSを使って推定する評価規準である。

現在、3種の基準が提案されていて、最小2乗規準は、ΣとSの行列の全ての要素の値の差の二乗和を最小にしようとする多重回帰分析や対応分析でもあった考え方である。

一般化最小2乗規準は、各要素の大キサに一定の配慮をしようとしている。また最尤法は出現分布を仮定している推定法である。いずれにしても、各要素の近似誤差を小さくしようとする評価規準となっている。

モデルの選択規準は、潜在変数の選択やその方向性と連結法を含むパス図や構造方程式を、経験的知見やデータとのバランスで、一貫して意味がとれるように選択するための、補助的規準である。AICや、BICやCIC等が提案されている。どれが良いかは、問題とデータに依存するため、一概に言えない。

モデルの検証法は、カイ2乗検定、GFI、AGFI等が提案されているが、いずれも評価モデルの尺度であるΣとSの各要素の近似度のバラツキを統計量として、検定法を構築している。

これもモデルの選択規準と同様、科学的と言える根拠を与えるものではない。

ただ、幾つかの経験的ケースから、GFIは、0.9以上が望ましいとされている。

ただ潜在構造分析は、観測変数を30以下が望ましいとされるが、もし30を超える場合は、GFIが0.9以下でも仕方がないとする見解もある。[豊田秀樹、共分散構造分析 入門編]

◆ 潜在構造分析への発展

因子分析は1960年代になってブレイクスルーが起きた。因子分析モデルの推定にあたり、理論的には既に提案されていた最尤法が、実際のアルゴリズムとプログラムとして実現したことをきっかけに、検証的因子分析が登場した。これ以降、従来のいわゆる因子分析は探索的因子分析と呼ばれ、区別されることになった。

SEM:構造方程式モデリング(Structural Equation Modeling)は、パス解析と検証的因子分析を統合し、柔軟で強力な表現力を持つ、応用範囲の広い統計モデルとして登場した。つまり、パス解析によって自由に変数間の関係をモデル化することができることに加え、検証的因子分析によって観測変数だけでなく潜在変数(構成概念)の間の関係をモデル化できるようになったのである。パス解析は観測変数のみのモデルであったが、SEMは潜在変数と観測変数の両方を、目的変数(従属変数)にも説明変数(独立変数)にも設定できる柔軟性を持つ。

SEMは、1970年代にアカデミアで理論的研究が進んだ。1980年代には実用的なソフトウエアが開発され、応用の時代に入った。日本では1990年代に参考書の出版が始まり、普及した。

産業界での応用は、日本経済新聞社の企業評価モデルであるPRISMが発表されたことで、定性的な構成概念を含む評価モデルに適用され、応用的な広がりにつながった。

しかし、優秀な企業とされた企業のランキングが、メディアで持ち上げられたいわば人気の反映を目的変数として、説明変数を財務諸表に依存する傾向が強かった。そのため、成長的要素が反映されず、優秀企業がすぐ息切れするような結果となった。

◆ 潜在構造分析の働き

潜在構造分析の働きをおさらいする:

・回帰分析ではできなかった内部合成変数を扱うことができ、意味が判りやすくなった。

また、 変数間の組合せ構造をモデルに組み込むことができるようになり、主観的な知見情報を組み込めるようになった。

・直接効果と他の要因を経由する間接効果を分離できることができるようになった。

そのため、間接要因変数や間接目的変数等のコンセプトを、その下部構成アイテムで説明できるようになった。

・回帰モデルの連立体系に比べ誤差の集積が抑えられるようになった。

さらに、多段階回帰モデルで増極された誤差の集積が抑えられるようになった。

◆ 因果関係の推定に関する限界と挑戦

まず、潜在構造分析の限界をおさらいする:

・共分散構造分析によってあるデータに最もふさわしい因果関係の推定が行われると考えるのは正しくない.

つまり、共分散構造分析は、データの背後にある理論に基づいて、変数間の線形な関係を表現するための仮説構造モデルを設定している。

そして、設定されたモデルを特徴付ける母数の推定を通じて、その仮説構造がデータと照らし合わせて、妥当なものと言えるかを分析する手法である.

・変数パラメータが増える傾向があり、回帰分析よりも脆弱性が高くなる。

というのも、変数構造部と各特性値を説明する構造部の2の脆弱性が高くなること。

さらに、内部合成変数は、客観性が無い場合は、主観性が必要であり、当らない場合がある・・・因果関係は構造モデルに事前情報として仕込まれている.

また、変数の関係を方向性をもって説明しても因果関係を示すとは限らない、つまり回帰関係でしかないことに留意すべきである。

・潜在構造分析の利点は、経験的知見や主観的変数を組み込むことができる点にある。そのため、モデルの必然性や説得性を高めるためのモデルの試行錯誤が大切になる。

従って、元のプロファイルデータを使って、変数間の意味を示す何らかの距離を使ったコンセプトの可視化ツールが欲しいところである。連環データMAPで検討するこの可能性は、続編で扱いたい。

◆ 夏イチゴを使った美味しいババロアを仕上げること

潜在構造分析の限界と挑戦について、すこし上で述べたように、コンセプトの意味の可視化ツールに関するケースを取り上げたい。

プロダクツやサービスの実現プロセスと客満足度との関係の構造を理解し、リファインすることで、コア・モジュールとしての、”美味しい夏秋イチゴ”の開発に成功したとして、その用途と用法を開発したいとする。

お誕生のケーキに欠かせないのがイチゴである。子どもは年間どの月でも平均して誕生日会があるが、夏秋のイチゴは入手が困難である。

例えば、夏には難しかった美味しい夏イチゴの栽培が可能になったとする。このコア・技術を使って、美味しいババロアを開発したい。

夏生まれの子供達もイチゴで飾られた冷たいババロア・ケーキを喜ぶだろう。つまり”用途”と”用法”を探索し、お誕生会で使える”コア・プロダクツ”を完成させる必要がある。

子どもを持つお母さん方は、健康安全志向で、ゼラチンを使わないで寒天パウダーを使いたいかも知れない。また、生クリームを減らして牛乳を使いたいとする。

ただ寒天はなめらかではあるが、ゼラチンのもつプルプル感が出ないので、固さを調整する必要がある。また酸味も大切なのでレモン汁を加えるとなると、牛乳は固まってしまう可能性がある。

[図7.4.16]

子供達やお母さん方に喜んでもらえる美味しいケーキとそのレシピとは?

そうしたケーキのレシピと生活者の出会いによって生まれる価値を知りたい。それには、相関関係性、回帰関係性、そして因果関係性等のどのようなデータ分析が有効であろうか。

データから役に立つ知識として、汎用性のある抽象的な知識と、実践する上で必要な具体的な経験的知識の両方である。

材料の”牛乳”や”生クリーム”等の「乳成分系」という抽象概念や、”ゼラチン”や”寒天”等の「凝固系」という抽象概念と、それらの抽象概念を規定している下部の具体的アイテムの関係がある。

一方、美味しさを構成する”なめらかさ”や”プリプリ感”等の「感触」や、”濃厚さ”や”後味感”等の「食味」等の、具体的アイテムと抽象的アイテムの関係性に関する知識が必要となる。

そして、操作要因と評価要因の関係の知識の獲得が、喜ばれるケーキというコア・プロダクツの開発の指針となる。

さて、これを、「連環データ分析」なら、どのように料理するだろうか?この続きは、続編をお待ちください。

地際に、現物でも開発をしないと、データを採れないからである。

§4.4クロス集計分析とその限界

◆ クロス集計表はいくつもの顔を持つ

データは通常、本来プロファイルデータとして得られる。

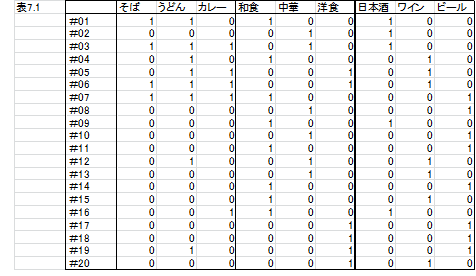

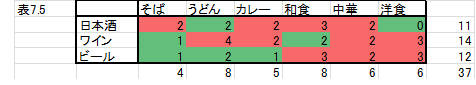

食事と飲み物の好みを20人に聞いたプロファイルデータが(表7.1)である。

通常良く食べる昼食のカテゴリーの”そば”、”うどん”、”カレー”の3のアイテムからのマルチ選択で、好み夕食のカテゴリーから和中洋のアイテムと、その時飲むアルコールのカテゴリーからと、”日本酒”、”ワイン”、”ビール”のアイテムからは、シングル・アンサーで答えてもらったアンケートの結果である。

内田治、すぐ分るSPSSのデータを参考に修正]

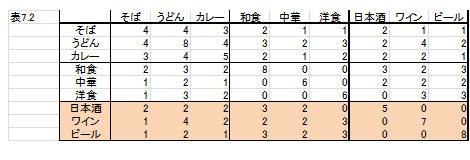

通常は、このデータを理解するには、通常総クロス集計表とかバート表と呼ばれる表に集約する。

これは、元データの行列を転置して元データの行列との積を採れば得られる。

いま、アルコール飲料と食事との相性:マッチングに興味があるとして、(表7.2)の一番下のアルコール飲料のカテゴリーの3行だけのクロス集計表を取り出して検討する。

このクロス表を最近流行のヒートマップで、分析して見よう。

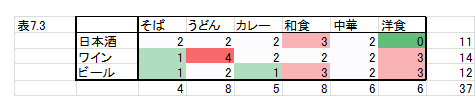

1)ヒートマップで全体の出現度の大小関係を見る。

一番多いのは、ワインと昼に”うどん”を食べる人の組合せが目立つ。一番少ないのは夜の日本酒と洋食である。

2)アルコール飲料カテゴリーの中の(行別)の特徴をみる。

日本酒を好む人なら、昼は何でもよく、夜は和食で洋食は駄目。

ワインを好む人なら、昼はうどんで、夜はやはり洋食。

ビールなら、昼はどちらかといえばうどんで、夜は和食か洋食。

3)食事カテゴリーの中の(列別)の特徴をみる。

昼が、”そば”なら夜は日本酒。”うどん”ならワイン。”カレー”なら日本酒かワイン。

夜が、和食なら日本酒かビール。中華なら何でも良く、洋食ならワインかビール。

4)飲料と食の主要なアイテムに注目する

最も好まれている夜のアルコール飲料は、ワインである。

最も好まれている昼食は”うどん”で、夕食は和食で、”そば”は人気が無い。

組合せでもワインは、昼が”うどん”の人と夜が和食である。

これは、縦と横の期待度からの単純な結果の組合せである。

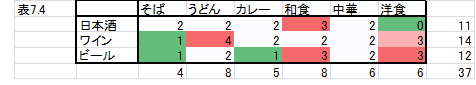

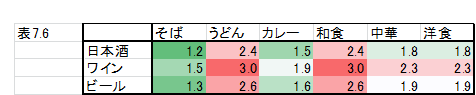

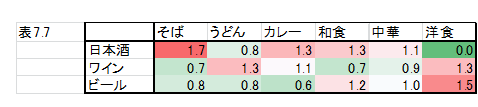

5)ヒートマップで全体の期待度からの乖離

単純な期待度から見て、その乖離度の多寡を計算して作表している。これの全体のヒートマップで乖離度の特徴を見る。

乖離度が大きくて、実際の出現度が期待度より大きいのは、昼が”そば”で、日本酒である。また、夜が洋食でビールの組合せも出現度が高い。

逆に出現度が低いのは、昼が”カレー”で、飲み物がビールの組合せである。

以上見てきたように、クロス集計表は、いろいろな意味を持っている。

ヒートマップは、強力な可視化ツールである。

ただ、本来プロファイルデータの分布をみるべきではあるが、何を見たいかによって、クロス集計表に集約し、5種類のヒートマップで分析するのが望ましい。

こうした、クロス集計表の分析には、通常対応分析:コレスポンデンス分析が使われる。ただ、このデータの場合は、3相のデータであり、多重対応分析:マルチプル・コレスポンデンス分析が良いが、市販されているソフトは、バート表に集約して、1相の扱いにしている。

本来、20人が、昼食と夕食と飲料の9次元空間上に布し、その分布を観察するべきである。

ただ、厳密には、このデータは、3相データである。連環データ分析では、回答者を分析対象主体:サブジェクトと呼び、その属性:アトリビュートと呼ぶ対象属性は、昼食と夕食とアルコール飲料の3個があると考える。そしてサブジェク・トアイテムは20あり、昼食アトリビュートのアイテムが3個、夕食とアルコール飲料のアトリビュートの各アイテム数はそれぞれ3個と4個あると考える。

すると、各3次元空間と4次元空間に20本のベクトルが布置されていることになる。これらの分布がある意味を失わないで同時布置し、それらの相関関係をその圧縮された空間上の距離となるような、分析を行いたいという要件が出てくる。

これについては、続編で考察したい。

◆ 各カテゴリーのアイテム間の独立性の検定:カイ2乗検定

一番使われるのは、カイ2乗検定である。

とはいえ、最近の1流ジャーナルは、形式的な有意差検定や有意性を示すp-値を使った論文の掲載をしなくなっている。

こうしたクロス表で、アイテム数が少なく、サンプル数も少ないデータでは、独立性の検定の感度が良く無い。

また逆に、アイテム数やカテゴリー数が増えるとP-値はどんどん小さくなって有意になる傾向がつよい。

その上、有意になっても、「だから、どうする?」という問題が待っている。つまり必要な情報は、意味のある結果で、使うことがでいる知識をそこから得ることができるかである。

また、ここではノミナル・バリアブル:食や飲料の名前に関する有無を「1,0」でまとめられる表示変数のケースを扱ったが、同じようなケースで計数型変数でも5種のクロス集計表として、それぞれ別な意味をもった分析法として扱うことができる。

◆ 集計表の限界とシンプソンのパラドックスの例

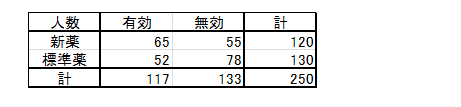

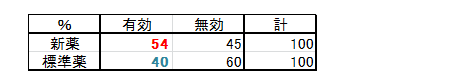

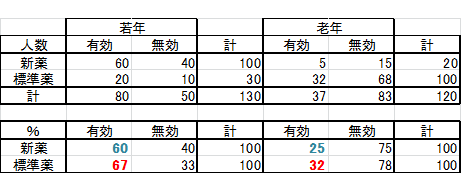

1)最初にサンプル全体の有効性を確認する。

例えば、新薬が開発されるとき、新薬が標準薬と比較される。このデータでは、新薬に120人が、標準薬に130人が処方された。合計250人である。

結果は、標準薬では、130人中52人が有効で、78人が無効であった。それに対し、新薬は、120人中65人が有効で、55人が無効であった。

[表7.4.18 ]

これを%で比較してみる。

新薬の有効率は、54%で、標準薬の46%を超えて大きく上回っている。

[表7.4.19 ]

尤度比検定でも、��2=5.07で有意となる

新薬

2)サンプルを年齢で層別して有効性を確認する。

・若者では、新薬は100人中60人が有効で有効率は60%なのに対し、標準薬は30人中20人が有効で何と有効率は67%と標準薬が新薬を上回っている。

・老年者ではどうなっているであろうか?

新薬は20人中有効は5人で25%の有効率に対し、標準薬は100人中32人が有効で湯効率は32%と、やはり標準薬が新薬を上回っている。

[表7.4.20 ]

若者と老年を全てプールした250人では、新薬が有意に優れているという結果であった。

しかし、若者と老年とに層別して主計した結果では、両方共に新薬は標準薬よりも有効率が劣っているという全く逆の結果になってしまっている。

これがシンプソンのパラドクスと言われる例である。

ちょっと変な感じがするもではなかろうか?例えば、選挙でいえば、男性にも女性にも人気がある候補者が、全部からのサンプルで集計してみたら落選するという予想となるということである。

関東でも関西でも人気がある候補のサンプルの集計では、負けるという集計結果となるという結果となるのと同じである。

その原因は、サンプリングにあるのだが、性別や地域別等の層に人気度の差が存在することと、サンプルの取り方が層といわばく交互作用があるような現象である。

◆ クロス集計表の限界と挑戦

クロス集計表は、多面的な顔や意味を持つ。そして、ヒートマップが、可視化ツールとしても、有効であった。

クロス集計表にまとめても、情報量は減少しないという考え方もあるが、本来のプロファイルデータだけが持つ意味は、幾つかある。

しかし、シンプソンのパラドックスに、見るように、意外ともいえる結果をもたらすことも見てきた。

また、先に、クロス集計表のヒートマップ法について5種類を示したが、これらは、データの情報圧縮を使う方法のデータの事前処理法としても、最低であり、これについては、続編で整理したい。

通常、クロス集計表は、元データは発生頻度等の計数値変量の場合が多いが、ある属性の有無を示す「1,0」でまとめられる表示変数:ノミナル・バリアブルでも、5種のクロス集計表として、それぞれ別な意味をもった分析法として扱われる。

いわゆる林の数量化3類や対応分析でも、その事前処理としてどのような処理をすべきかは大切である。

さらに、計量値では、主成分分析等があるが、この5種の処理と関係する元データの事前処理の意味の理解は大切である。

また、順序変数:オーデナル・バリアブルの扱いは、マッチング問題等の広範な応用領域が広がっているが、まだまだ、発展させる必要がある。

加えて、プロファイルデータが持つ多次元データの分布情報は、多様な応用法がある。周辺情報は、1属性であればヒストグラム、2属性であれば散布図などで可視化できるが、多次元の分布状態を可視化する方法は、まだ発展途上と言える。

特に、計量値や計数値やオーデナル変数やテキストが入るノミナル変数等が混じる多変量の分布状態に関する分析法は、開発が急がれる。

この種のデータを含むプロファイル・データを直接可視化する問題も、「連環データ分析」を含め、続編で検討したい。

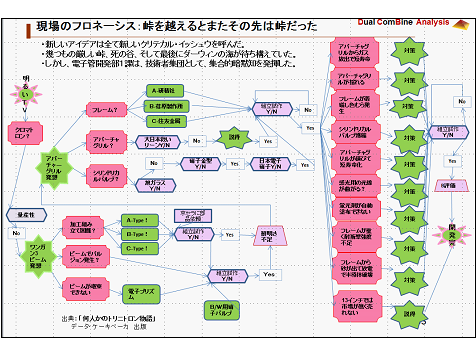

※◇ 多くの峠を越えた3のケース

ここでは、フェーズ3.0での具体的ケースを紹介する。

それは、このプログラミング・フェーズの活動や、問題のタイプやデータのタイプや、それらを使って、各種の方法論がどのような役割を果たす必要があるか、またその限界について理解して頂くためである。

§※.1 トリニトロンブラウン管

◆トリニトロンというカレーテレビのプロダクツをデザインした

トリニトロンのケースでは、コア技術として”ワンガン・スリービーム”という発明は、制限されたディスプレイのガラスネック径の中で3個の小さな電子レンズを並べるのではなく、1個の大きなレンズを置き、それをRBG3色の電子ビームを交差させて共通に利用しそこを通過した後分離したビームを再び蛍光面で収束させる仕組みであった。

3色のビームが交差したとき、相互反発してビームがバラバラになることが懸念されたが原理試作で、明るくするためビームをどんどん入れても大型レンズは効果があり、相互反発が起きないことが実証できた。

このコア技術を使って、カラーブラウン管というコア・モジュールを使い、実際のカラーテレビというプロダクツに組立ててみると、明るさのKPIは、良かったが、画質が物足らなかった。

テレビを写すブラウン管は、カソードから3色の信号を帯びた電子ビームが飛び出し、電子銃でフォーカスされ、蛍光面に当って光る。ただ、その蛍光面には、3色に発行する蛍光帯があり、3色の信号を帯びたビームだけがそれぞれ専用の蛍光帯にだけ届くようなビームの色選別機構が必要である。ソニーは、トリニトロンに辿り着くまでに、クロマトロンで量産に失敗していた。ただ、そのクロマトロンが、画質のベンチマークとなっていた。

クロマトロンでは、色選別機能が、細い縦線で、蛍光面も細い縦線であった。画質の鮮鋭度は、そこからきているとプレジェクトメンバーは、一様の見解を共有していた。また、そうかと言ってクロマトロンの色選別機能は、高圧を超高速でスイッチングする方式でスジが悪く、また蛍光面を作成する工程で、写真技術を使えないため、蛍光面のガラスパネルと色選別機能に互換性を持った工程を実現できなかった。

では、ストライプ状の色選別機構をどのようなコア技術を開発し、どのようなコア・モジュールにするかという、いわば振出に戻るような結果となった。

そこへ大日本スクリーンが、プロジェクト・リーダの大越の所に、0.1ミリの厚さの鉄板に細いストライプ状のスリーットをエッチングで明けるという提案を持って来た。

大越は喜んで、それをステンレスの枠(フレーム)に組んでそのスクリーンをピンと張る構造をポンチ絵に手書きし、同じ課に居た旋盤職のお爺さんに渡した。すぐに3台分の鋼材からフレームの上下のAメンバと左右のBメンバーの2本セットが即日削りだされ、これをフレームに組み立てるため五反田にあった街工場の熔接所に依頼した。

大日本スクリーンからも数枚の試作が届けられた。フレームを上下に撓ませ、スクリーンを、梅木信友がつくった手軽な電気溶接機で熔接し、中山昭が不要な歪を焼鈍し、仕上げして、蛍光面作成の井上卓二に渡した。井上は、写真技術で蛍光面をRGBのストライプ状に焼きつけたカラスパネルと対の色選別機構を中山に返した。中山は、それをガラスファンネルと一体とする高温炉に入れ、ボトルネックに電子銃を入れ封じ、真空にてブラウン管を完成させた。

トリニトロン・プロダクツの完成だった。ただ、それからが、このプログラミング・フェーズの本格的活動の始まりだった。

#1.アパーチャ・グリルが揺れる

新しい色選別機構はアパーチャ・グリルと命名された。ただ0.1ミリの厚さの2ミリ幅の鉄板は、フレームを数キログラムで上下に数ミリ撓めて、そこに熔接し、撓めを緩めて弓の弦のようにピンと張ってはいたが、ブラウン管の中は真空で、外から少し叩いただけで、振動して止まらなかった。振動すると3色のビームが異なった色を叩いて、虹色の模様を造ってしまった。

現場で数人が集まりブレーン・ストーミングとなった。そこを通りかかった社長の井深は、横に細い線をメッキで付ける提案を出したが、中山は、言下に却下した。

やがて現れた課長の大越は、電球から取り出したタングステンのフィラメント・コイルを、それをエイヤーといい加減に引張り、その左右を細い板バネで引っ張る構造を提案した。コイルとAGのピッチとの関係が心配されたが、見事に解決された。タングステンは、当ったビームをチャージせず、陰を造らい材質だった。

#2.フレームが着磁し色むらを起こす

AGのフレームの上下メンバーと左右メンバーは、別々に成形され、アセチレンバーナで熔接組立てされてほぼ4角形に構成される。ブラウン管にしたとき、この4隅近くが色づれを起こす現象が出た。いろいろ原因を探索したが、高温のアセチレン熔接で、着磁が起きていることが想定された。また、AGをフレームに電気溶接する時にも、着磁をさせていることが想定され実際に計測できた。仙台工場と仲が良かった東北大に相談したところ、キューリー点まで高温にして、徐冷すれば、脱磁が可能とのことであった。ただ、AGを張った状態で高温にすると、AGはするめの様に伸びきってしまいお釈迦になる。

梅木は、銅線を仕入れ、数百ターンの太さ10センチにもなるコイルを巻き、それを50センチ四方の土俵を造り、重量に耐える台車に積んだ。それに電磁衝撃波を加える電源を手作りし、その中にAG組立てを寝かし、ドスンと脱磁波を加えた。実際の効果を出すために、出力を上げ次第に大型になってそこまで行ったのである。幸いその処理によるAGのピッチムラは起こらなかったが、1階にあった開発部での脱磁の衝撃は、7階にあった役員室まで、響いたようではあったが、無事解決した。

#3.光が真っ直ぐ走らない

トリニトロンは、最初から12インチのブラウン管をターゲットとした。それは、世界初のオール半導体のカラーテレビを目指し、それが可能な最大のサイズをねらったからである。

AGは、幅20ミクロンの隙間を持った20センチ高さのスリットが、数百本のリボンでその上下は繋がった形で構成されている。

これがフレームにピンと張られてAG組立てとなる。

これをブラウン管の前面のガラスパネルに蛍光剤を薄く塗布し、固定し、露光台に乗せ、下から赤、緑、青と次々にランプで照らして感光させ、現像しRGBの蛍光剤を形成する。写真技術である。

ところが、どうもストライプの中央だけが感光不十分で良く現像できない現象が起きたのである。

井深は、この感光作業の効率を上げるためにこの集光レンズを蒲鉾型にする案に固執されていたが、それどころでは無かった。

原因は細いスリットでは、光の回折現象が起きて、スリットの中央部には、光が真っ直ぐ届かないという現象を若い物理専攻だった前田誠が指摘した。

ではどうするか、問題の現象を発見したものがその対策を考える。前田は、光が悪い癖を出して勝手に曲がるのなら、光源を揺らしてしまえと考えた。いわゆる光源のオーブリングである。これで格段に作業効率をようやく向上させることができた。

#4.蛍光体が上手く塗布できない

ブラウン管の構成部品の仕様がすべて決まってからその製造装置や検査装置を設計し、発注し工場に据え付けたのでは、計画はどんどん先に逃げて行く。

生産技術を担当していたメカ部隊の横内猛のGp.は、開発Gp.の各専門の担当者と机を並べて、製造装置の開発を進めていた。

その単独の蛍光面作成する装置での異変が、蛍光面の清作プロセス担当の井上から朝礼で報告があがった。

シャドウマスクでは前面のガラスパネルは、球状の一部を切り取った形状であるが、AGはすだれ状の薄い鉄板を真っ直ぐ引張っている関係で、円筒状になる。これが問題の現象を引き起こしていた。

蛍光体は、感光剤と混ぜ合せ、どろどろのスラリー状にしてガラスパネルに流し込み、パネルをその中心で回して、薄く延ばして余った分を、いわば遠心力で外に弾き飛ばして塗布する。

ところが、トリニトロンのパネルでは、4隅が丸く無く角ばっているため、上手く外に弾き飛ばせないで折り返しそこにスラリーが溜まってしまうのである。

井上以外にこの対策を検討する余裕を持った者は居なかった。井上は観察した。スラリーは、パネルの回転につれて4隅に集まり、また折り返す。折り返して重なり合う。重なりあってそこだけ厚くなってしまう。それをチューブなどで吸出しすこと等では、到底均一性は確保できない。

遂に井上は、回っているパネルに顔を着けて息で吹き飛ばそうとして、ひらめいた。

少し厚紙を4x6センチ位切り取り。大型の紙ばさみで、パネルの隅にそれを取りつけたのである。それはちょうど井上が息を吹きかけようとしたような風を起こし、スラリーを噴き出したのである。

”大越さん、ちょっと来てください”。大越はやってきて、目を大きく見開いてびっくりした顔を見せた。井上にとってそれは、最高のご褒美であった。みんな、大越や吉田や井深が共に悩んで、そして解決を喜んでくれるのが、何よりも嬉しかったのである。

大崎工場にどんどん横内Gp.が設計した製造装置が運び込まれていたが、それらの内の蛍光体塗布装置の運転法が開発された瞬間であった。

#5.衝撃テストでAGフレーム組立てが外れる

プロダクツは、最終的には梱包されてコンスーマの手に届く。

その梱包の設計が大きなコストダウンにつながるというアドバイスは、松下電器の幸之助さんから井深に届いた。誰か若い者を門真に見学にきて下さい、と。

クロマトロンでは、耐衝撃性は15Gしかなかった。アメリカン・エアーラインに10インチを納入したとき、アメリカ連邦規制局:FAAの航空機規格では、不時着時に15Gで破壊的事故を起こさないことという規定があった。

これはかろうじてクリアしたが、色選別機構がブラウン管の中で外れる現象が起き、15Gでは、全てが不良品になってしまう。

一端納入した20台のクロマトロンを、第1開発部の若手と女性陣がそれを泣きながら壊したことがあった。

加藤の信頼性Gp.の若手が松下電器本社の門真の正面の門を入ってすぐ左手にあった「商品検査所」と板切れに墨書された事務所を訪れた。

そこで見たものは、ただ身長測定器のような梱包された製品の落下試験機と、大きな6角ドラムが少し斜めに回転して中に放り込まれた梱包された製品がゴロゴロと崩れ落ちる様を再現するまさに実際の現場の助状況をそのままに再現するプリミティブな装置群であった。

ソニーでは、半導体の開発の時からMIL規格仕様の衝撃テスト機と振動テスト機を導入していた。それらはあくまでいわば裸のプロダクツの対衝撃性や対振動性を計測するために使って製品の裸の単体の能力を評価しているに過ぎなかったのである。つまり、それらを使用する条件は別に分離され、梱包仕様として、許容差をもってデザインすることを想定していたからであった。

また、この大塚市兵衛所長は、もしこの検査所で不具合が検出されたときは、担当の事業部長に「1の連絡書」が発行され対策法が検査所に返る仕組で、もし1週間以内に返らなかった場合は、大塚さんから幸之助さんに直接電話が行くということで、これにもびっくりした。

トリニトロンでは、重いAGフレーム組立てをガラスパネルに固定するため、クロマトロンやシャドウマスクが使っていたようなガラスパネルにリン青銅のピンを埋め込む方式ではなく、セラミック粉末を焼き固めたセラミックピンをパネルに押し付け高温炉でガラス糊で付ける方式とした。

これによって、リン青銅ピンがガラスパネルからもがれるより対衝撃性が格段に良くなった。ただ、ピンは強くなったが、ピンとそれにはめ込まれたAG組立てを支える板バネが滑ってバルブの中で落ちてしまう現象が40G位で起きてしまった。40Gという衝撃強度は、玉子やヒトの頭脳の耐衝撃性であってとてもプロダクツとは言えない。

中山は、それに対し、直ぐ板バネとフレームの隙間にリテイナを称する小さな金属片を挿入する構成を考えた。

衝撃強度は、60Gとなり、梱包材は、薄くなって、USまでの輸送コストは、何千円かの単位で安くなった。

ソニーでは、商品の耐衝撃性の評価尺度は、まず、そのサイズファクタから規定し、次に、製品の対衝撃性は、それに加える衝撃波形を正確に再現できるMIL仕様の衝撃装置を改良して、合理的な梱包設計が理論と共に可能となった。

そのため、ソニーは、輸送中の衝撃のデータを測定するため、ダミー商品を、世界各国に送った。振動についても同様なデータを採り、梱包設計の理論と評価体系を開発した。

また、信頼性に関する連絡書の仕組は、松下さんのまねをさせて頂いた。ソニーの高品質・高信頼性の評価に幸之助さんのアドバイスがあったのである。

#6.AGが炉の中で錆びついてしまう

大崎工場で少しづつ試流しの生産が進み始めたころ、ある週明けに大きな問題が見つかった。

AG組立て後に、その歪をとり、パネルガラスとの相性を安定させ、セラミックピンを付けるためのスタビライザーの炉を開けたとき、炉の中のAGが真っ赤に錆びていたのである。

AGは、薄い鉄板を塩酸でエッチングし、鉄を溶かしてスリット状の隙間を形成している。塩酸はその後水で洗浄しているはずであるが、鉄の中に浸みこんでいる。

これもあって、高温の後時間が立って錆びが出たのである。もし、塩酸の成分である塩素が残っていれば、ブラウン管の中で、それは電子を発生させるカソードにダメージを与え、ブラウン管の寿命は短くなる。シャドウマスクでは、このスタビライザ工程をもっと高温にし、水素を吹き込んで塩素を還元してしまっているが、AG組立てはそんな高温に耐えられない。

大崎から呼び出された本社の開発部の中山の製造工程仕様書には、これに対する処理法は記載されていなかった。

30億円掛けた大崎工場の生産設備は、生産ができないガラクタの詰まったお化け工場になる危険が出てきた。

中山は、必死に考えた。AG組立ては、炉の中でどうして赤錆となるのだろうか?これでみんなの苦労は水の泡となるのだろうか?

大日本スクリーニングが、初めて数枚のAGのエッチングの試作品を、紫の風呂敷に包んで重役さんが京都からわざわざ届けてきたとき、中山がすぐ眼の前に広げて透かして見て、”あっ、これは駄目”と次々と横に押し戻して全てを不良品です。とキメ付けてしまったことがあった。役員は顔色を変えて帰京されてしまったことがあった。

驚いたのは井深以下のトップ陣であった。大日本スクリーンにプロジェクトから降りられたら、プロジェクト自体が行き詰ってしまう。慌てた井深はソニーが調達できる現金をかき集め、出来て間もない新幹線に飛び乗って京都の本社に向かった。株を買い、必死の説得で、想い留まってもらったこともあった。

その後中山は、大日本スクリーンの工場に行って、このSGが如何にミクロン精度を要求するのかを説明し、その工程でAGを投げてうち傷を付けるとそれが画質に現れることを理解してもらい、丁寧に扱ってくれるように御願いをして頂き、各段と良い試作品が届けられるようになっていたこと等もあった。

中山は、少年時代に田舎の五右衛門ガマの修理の職人のことを思い出した。その職人は、穴の開いた所に鉄の鋲を打ち込んで塞ぎ、その後不思議な処置をしていた。青い松葉をかき集め、それに鋲打ちをした釡を上から伏せて火をつけて燻したのであった。窯業工学を専攻した中山は、理論家というよりも生粋の技術屋であった。

彼は、助手の女の子に、食用の菜種油を五反田で買ってきてくれと頼んだ。自分は、何枚かのAGを用意し、鍋と電気コンロを用意して、自分の職場で実験しを開始した。

鍋を加熱し菜種油を気化させAGをそれに晒した。いわばAGの菜種油による燻製である。それを今度は、高熱の電気炉にいれ加熱した。結果が出たとき、夜中の12時を回っていた。大越を呼んだ。大越は「あっ」と声を挙げて確りAGを見つめた。そして声を詰まらせ、うん、うんと肯いた。

それは鉄の見事な黒化処理であった。それから20年後ドイツで低温黒化処理法が開発され論文が出た。新日鉄がその技術を使ってシャドウマスク用の内部のスカーフの黒化処理された鉄板をWebで販売を宣伝した時は2000年近くであった。

黒化鉄は、2酸化鉄の赤錆では無く、四酸化鉄の安定した黒金だったのである。

中山がアルミの鍋で菜種油を焦がす度に、旨そうな天ぷらの臭いが本社の1階から役員の居る7階まで立ち込めて、皆が昼を待ちまねて12時の食堂に早く押しかけた。またそれだけでなく、全ての廊下のピータイルがつるつる滑って危なくなっていたが、ソニーはそれで救われたのである。

#7.ガラスバルブが爆縮してしまう

いろいろな難問が次から次へと降って湧いてきた。皆はまた、”問題だぁー”と叫んだが、プロジェクト・マネジャの吉田は、嬉しそうに微苦笑する以外に無かった。やがて誰かが、解決してくれると。

ただ、ブラウン管が、最後の排気炉の中で、爆縮の連鎖を起こしたとき、多くのメンバーは、これで全てが終わったと考えた。

受像機を組み立てていた製造部長が、血相を変えて大崎工場の新館のラインから、本社の開発部に飛び込んで来た。

「こんな事故は前代未聞、もしセットの組立てラインで爆発が起き、女子社員が負傷したらどうするのか、このプロジェクトは即刻中止する」と。

まだ防爆処理が施されていないブラウン管をセットに組み込む作業者達は、全身を危険にさらすことになる。

大越は、ガラスパネルを成形していた日本電気硝子からそのメス型を全て引き上げ、ソニーの工作部のNC旋盤で1ミリ程掘り込んで、また大津の工場に送り返した。

それで、全てが解決したのであった。まさにカミワザと思われた。ただその陰には石原忠夫というCADの専門家が居た。彼は有限要素法の論文が東欧で発表されたのを読んで、日本はもちろん多分世界でも最も早い時季にフォートランで強度計算ソフトを開発していた。

そしてトリニトロンのような球形でないガラス形状が、1センチ平方当り1キログラムの大気圧に晒されたとき、どこにテンションが現れるかのシミュレーションを繰返していたのであった。

そして実際のガラスバブルを使ってテンションやコンプレッションの分布を計測し、シミュレーションに必要なパラメータを追いこんで、まさにデジタルツインモデルをリファインし続けていたのだった。

そのER:エンジニアリング・レポートと実験を見ていた大越は、ぎりぎりの肉厚にしていたが、どこをどの程度肉を盛れば良いかのモデルが、その彼の脳内にイメージできていたのである。

メス型を1ミリ削ればカラスの肉厚は1ミリ程厚くなる。肉厚を薄くすることはできないが厚くすることはできる。これは、大越の有る意味で読みの内であったのである。

もし、ガラスの成形金型を作り直すとすれば、20億円かかりさらに半年以上時間が失われることになり、ソニーカラーテレビに参入することは困難になっていたであろう。何より既にソニーには資金が枯渇していたのである。

次から次へと難問は、降りかかってきた。

極め付きは販売担当の盛田副社長から、「13インチのカラーテレビという市場は無いので営業部隊は売れない」と言っている。

「19インチに変更できないか?」と吉田がこっそり呼び出されて打ち明けられた。吉田は、下を向いたまま答えた「それでは販売は1年半程遅れますが宜しいでしょうか?」と。

こうした数多くの峠を越えた度、毎朝のF-PETチャートを見ながらの第一開発部1課の全体ミーティングで成果として報告され、全員がその進捗を悩みも喜びも共有した。

全てが絶対絶命のように思われた。ただ、全てをこのプロジェクトは、切抜けて、”家族みんなが夕飯の明るいテーブルを囲んで楽しむことができる明るいカラーテレビを開発する”という駆動目標を共有してがむしゃらに突き進んだ。

それは、明確でスジの良い強い唯一の目標と、体験的集合知を発揮する場の設えと運営法が有ったからと思われる。

§5.2 ベータ・マックス

#1. クロミテープは問題だ!

ベータプロジェクトが発足したとき、本社の専門スタッフから懸念が指摘されたのが、テープの磁気記録に2酸化クロミが使用されている点であった。当時イタイイタイ病としてクロミテープは難しのではないかという指摘であった。

ただ、仙台工場は東北大学と産学連携の成果でフェライトの技術の蓄積があり、コバルト剤を使ったテープを開発し、さらにマグネヘマ等の鉄系のグレンサイズの細分化法の開発と、薄く均一な塗膜生成プロセスの開発に成功して行った。

#2. テープがずっこける・・・カニの褌

カセットサイズをソニーの社員手帳のサイズを目指した木原は、当時採用できるテープの磁性体のグレンサイズ、それに信号を書きこみ読み出すための磁気ヘッドの薄さ、ヘッドのギャップの狭さ、ヘッドの浅さ等の極限を追求し、テープ幅1/2インチで45分間の記録再生が可能であると原理試作をしていた。

これがまた、本社の専門スタッフからの懸念に繋がった。つまり今回のベータは、1/2インチで磁気記録ビデオテープとして最終のフォーマットとなるであろう。もしこれでソニーだけが開発を先行したら、USから独禁法で訴えられる可能性がある。というものだった。

こうしたリスクの指摘は、法務部門や本社の技術企画部門などから提起され、河野が率いる技術準備室は、里親の吉田が率いるトリニトロンのスタッフ等の支援を受けて、毎月開催されたソニーのトップによる経営会議から、”ベータマックスプロジェクト延期の決定」に対し、丁寧なしかし反論の資料を作成し凌いでいた。

ただ、こうしたトップマネジメントが急がない姿勢もあり、時間的に余裕ができた。こうして7回に及ぶ大掛かりな試作が可能になり、ベータの技術は成熟して行った。

カセットをコンパクトにできたのは、ヘリカルスキャンとアジマス記録というコア技術であった。

ヘリカルスキャンは、頭石場の澤崎博士の特許技術で、テープ幅に対しその上端から下端までに斜めに1直線でテレビの画面を構成する水平成分を記録する方法である。テレビの一画面は、525本の水平成分で描かれているので、もしそれを0.1ミリのトラック幅で記録再生できれば、52.5ミリだけのテープの長さで十分となる。

木原信敏は、このヘリカルスキャンの技術をベースに、ヘッドを薄いドラムの腹に2個のヘッドを180度でマウントして、これを高速に回転させ、それに対し斜めにテープを送って行く仕掛けを開発した。井深は、東芝が放送局用の高級機を、ソニーがコンスーマ用の安いVTRを造ろうと東芝と話を着けた。

ただ、こうして525本のトラックで記録してこれを再生しようとしたとき、記録したトラックを確り踏んで走らないと隣接したトラックに踏み込んでしまうと、信号が混信状態となり、映像が乱れてしまう。そのため、トラックとトラックの間に通常はガードバンドという信号を入れないゾーンを設けるのだが、ベータでは、木原が一対のヘッドを捻ってマウントするアジマス方式を開発した。

これはトリニトロンがAGで縦方向の信号の公差を一気に拡大したのと似た公差の拡大というコア技術であった。

また沼倉俊彦は、輝度信号の下側に色信号を低域変換して同じトラックに記録する「カラーアンダー方式」で特許を取得した。平井純は、輝度信号と色信号を帯域のロスを少なくする分離方式で、特許を取得し、画質向上に寄与している。

このガードバンドを無くしてべたにテープに無駄なく記録することで、吉田進が方式をベタ記録で良いではないかとして、ベータマックスと呼ぶことになり、シュッポシュポとソニーを牽引するSLを型番に採用することにした。

とはいえ、テープカセットを水平にセットし、それに対し高速に回転するドラムを傾斜させてセットし、そのカセットからテープを引っ張り出してドラムに巻き付け、薄く柔らかいテープと固いヘッドをマウントしたドラムとが、安定して走行する状態を作り出すのは、意外と難しい。例えば早送りやストップや巻き戻しなど、ヒトが勝手なタイミングで介入してくる。カセットからテープを引き出すピンチローラに抵抗する仕掛けをカセット内に設けてあるが、1度ゆるんだテープを巻き戻すまでには行かない。ゆっくり再生や記録が進み始めたとき、自働的に正常の走行状態に復元しなくてはならない。そこで、テープとドラムガイドとカセットの3者の協力関係が必要となる。これをカセット側に仕掛けを造ったのが、俗にいう釜屋の蟹の褌である。若い釜屋はテープの気持ちになって、テープがずっこけて下に落ちないように、下からそうーと支えてあげる手である、これは蟹が子をその腹の褌の中に抱えている様子からのニックネームであった。その褌は、普段カセットが単体で居る時は、テープカセットの蓋の役割を果たしているのである。

これも、エッセンシャル特許群の一つで、VHS陣営からも毎年数百億円のライセンス収入をソニーにもたらすのに貢献した特許に1つである。

#3. テープ・ステッキング現象

トリニトロンのプロジェクトで、井深がF-CAPシステムを開発したとき、そのプロダクツのいわば一生を事前にレビューするデザイン・レビューを発展させたプロスペクティンというマネジメント技術の開発が試みられた。

当然ながら、ベータマックスが冷たい部屋から暖房の効いた部屋に持ち込まれたとき何が起こるかというデザイン・レビューが実施される。

するとテープがドラムに張り付いてしまう。それは冷たいドラムに水分が露結するからである。張り付いて止まらなくてもテープがステックして、スムーズに走らなくなる。それで画が揺れる現象が起きる。

これには、取説に注意書きを入れたり、ドラムの表面に風が当るような装置を付けたりする等の対策を取った。

#4. ファインパターンIC回路開発

トリニトロンで始まったバイポーラ型ICは、ターゲット・ドリブン型もあり厚木工場が世界最先端を走っていた。カラ―信号処理回路は共通である。厚木ではプロセスの細密化を進め、ファインパターンでIC化のプロセスを開発した。

このファインパターンICで回路を設計するとき、問題が起きた。回路をデザインし、回路集約するためのブレッド・ボードシステムでの、実証確認ができなくなったのである。

ブレッド・ボードは、料理の”まな板”の意味であるが、ファインパターンのトランジスタ片を切出し、これに抵抗やコンデンサやコイル等を繋いで、信号処理が機能するかの確認作業である。これで確認して、IC回路を決定し、ICの製造するプロセスに必要なパターン型を何枚も起こすのである。

理由は、ファインパターンのトランジスタの内部抵抗や内部容量等が小さくなり、それらをつなぐ外部のリード線の抵抗や容量等の効果が邪魔になって、実際のICとは異なった振る舞いをするようになってしまったのである。

当時、日本は、回路のCADの理論で世界の注目されていた。NECの渡辺和氏を中心に。東大の伊理先生や慶応大等が”幾何学的最終自由度”の概念を使って回路の振る舞いの計算を最小化できるというもので、ソニーの中央研究所も参加していた。

ただ、期待されたマトリックスを最小化する方式は、そのマトリックスを求める時間がかかり実用化できなかった。

しかし、トリニトロンでは、材料力学では世界に先駆けて有限要素法を実用化していたが、電気回路の計算でも、技術評価Gp.の嵯峨根勝郎が、スパース性を巧みに使ったCADシステムを開発していた。

そして、数個のファインパターンプロセスから試作されたトランジスタから、多次元のパラメータの分布データを得て、それに従う無数のトランジスタをシミュレーションで造り出し、その後ブーストラップ法と言われる方法で、人工データを発生させ、強化学習プロセスまで完成させていた。これにより、第3開発部の石垣Gp.が開発したIC回路の特性分布のシミュレーションが可能になっていたのである。こうしてICの回路集約ができた。

現在、デジタルツインが注目されているが、まさにデジタルシングルだけて、開発できたのである。

ただ、里親の吉田進は、このICの外販を拒んだ。マスタドラムのノウハウの開示も拒否した。

こうしたこともあってか、松下・ビクター連合は、ソニーとの交渉を長引かせ、その間に長時間録画用のカセット開発を陰で急いでいたのであった。

#5. 45分では短すぎる

ベータの最終決定の経営会議は、松下からの返事を待つため、7か月間続いた。

いろいろあったが、独禁法に引っ掛かりかねないという法務部門の主張が、社長になったばかりの盛田さんを苦しめた。プロジェクト側は、成功してからその対策を考えましょうと強気だった。次から次に中止の理由が変わった。

なかには、ちょうど第1次オイルショックの到来で、プラスチックが数倍に値上がりしたこおとを受け、ビジネス・マスタ・プランの見直しを迫られた。価格目標は不可能ではないか、というものであった。大崎側のスタッフは、達成目標が明確で、その意味と理由が明確で、成長する筋書が明確である。プロジェクト・メンバがぶれない限り絶対に達成できるとし、研究していた組織的集団学習の経験法則を、使って反論したこともあった。

ただ、プロジェクトに反対するその極め付きが、45分間では短い。60分にするというKPIの方針変更であった。テレビ番組では、USで野球は2時間を超える場合もあり、これは方針の問題であった。理論であれば、反論できる。ただ、方針変更には反対ができなかった。

今更、カセットサイズは変えられない。テープを薄くする以外にない。これがとんでもない問題を引き起こした。テープの厚さを3/4にするとその曲げに対する抵抗力は、その3乗分も減少する。

いきなりが揺れ現象が発生した。これは、ウオータフォール現象とニックネームが付けられた。

テープとドラムの摩擦を減らすため、ドラムの表面にガラスの球を埋め込む案やテープの材質を検討するか、テープにパラフィン剤を入れる等の検討が続いた、苦戦し続け、この解決に1年が費やされた。この時間は、まさに敵に塩を送る結果となった。ベータの敗因の一つである。

#6. 西洋や国際規格への対応と長時間録画問題

一方、ソニーとしては、ベータのカセットのハードフォーマットを世界規格にしたいという明確な意識があった。

問題は、USや日本は、テレビの放送規格がNTSCであるが、フランスとソ連はSECAM方式で、残りの多数の国は、ドイツとUKのPAL方式であった。これらの方式は、テープの使用料が増え、60分の記録ができない。

ソニーの技術企画室が主宰する大きな技術戦略会議が7階で開かれた。NTCSをICでPALに信号変換する方式やドラム形状を変更する方法や画面を構成する1本分を記憶させ間引きする方法等が検討された。

同じ日、4階の技術準備室の1角で、中山正之は仙台工場に頼んであった不良品のヘッドの山から最も薄いヘッドを選り分けてドラムに組み込んで映像信号をオシロで確認していた。

やがて、技術準備室長でプロジェクト・マネジャだった河野が会議を終えて帰ってきた。

どうでしたかと聞いたが、芳しい返事が無かった。「ちょっと見て下さい」と中山がそのメカに胸を張って案内した。

それはトラック幅を半分にしたシステムだった。「えぇー、大丈夫なのか?」。「トラックのエッジに信号密度が高く記録できるから幾ら細くしてもOKですよ」と。

これが、やがてVHSとの時間競争に発展しても、基本的な思想になったのである。ただ、ソニーの特許を無償で利用できた松下とビクターは、ソニーが開発した技術を直ぐVHSにアプライし、カセットが大きい利益を享受し続けたのである。

フォーナットの仕様は、カセットとドライブメカのインターフェースで規定され、動かすことができないのである。

中山は、それまで、UマチックというⅠ世代前の世界初のカセットテープを使って、デジタル記録のテープでドキュメントリトリーバルシステムを開発し、IBMがコンピュータの外部記憶装置に磁気テープの開発や8インチのフロッピーの開発の切っ掛けを与え、ソニーの3.5インチのフロッピーデスクの開発を行うことになるのである。

#7. プロダクツコンセプト

当初、このベータの用途や用法について迷いがあった。準備室発足がプロダクツ・デザインのフェーズであったが、それと同時にカメラの開発、ポータブル型の開発、ソフトのダビング用マシンの開発も同時進行形となった。

ただ、ビデオカメラとダビング・マシンは、当時厚木工場でUマチックを使った業務用の情報機器事業本部が担当となった。ただカメラは、目標としての15万円にはとても届きそうにはならずおまけにビデオケーブルは、3メートル位しか長くできず、ベータ本体をリビングに置くと、裏庭の洗濯物位しか写すことができなかった。

盛田は、思い切って、これは「ビデオテレビである」として、18インチのトリニトロン・テレビと一体型とした。チャンネルを合わせテレビを写しながらこれを記録する。これを後ほど再生して見ようとするコンセプトであった。

確かにこのプロダクツスタイルは、どのチャンネルのどの時間の番組を録画したいかは、非常に簡単に理解し、操作できた。それは目的のチャンネルの選択が、使い慣れたテレビそのもので、画像でも選んだチャンネルの画面で確認ができたからでもあった。またタイマーの設置も簡単であった。宣伝も、タイムシフトに徹底し、母親が子どもに”宿題をしたら好きな番組を録画してあるので見せてあげる”と機能に特化して理論的に説明するものだった。

しかし、営業からはテレビが余計であると、評判が良く無かった。特にUSからは月に300台か600台位しか売れないとラゴアや強気で鳴らした鵜木部長からも不評であった。

この段になって、トップに焦りが出た。

河野は、チューナ・モジュールを別に開発していた。

それまでSL6300としていたデッキにチューナブロックと着け足したSL7300を単体のデッキとして商品化する企画に切り替えた。

当時、ラジカセが普及し、音楽のエアーチェックという言葉が社会に浸透し始めていた。河野は、これでテレビのエアーチェックができる時代を造ると言い切っていた。

ようやく営業からほっとした空気が返ってくるようになった。また、OEM担当からも似た反応があった。

ベータマックスは、こうして映像コンテンツの流通を担う、プラット・フォームとしてのメディア・プロダクツとしての用途と用法、そしてその様式と様相を確立したのである。

§5.3 3.5インチ・マイクロFD

#1.カセット型の用途と用法のソフトウエアの探索

フロピーデスクとしてのカセット化は、やはり、カセット型の用途と用法とその使い方としての様相つまり、ソフトウエアの探索が問題であった。

当時、1980年はその年明けから、まさにアメリカは、オフィス・オートメーションOA元年だった。ビジネスウイーク等の経済誌だけでなく、ウオールストリートジャーナル等の日刊紙も、書きたてていた。

IBMの360等のメインフレームは、1960年代から、デジタル技術特有のダウンサイジングが急速になる。

まず工場用のプロセスコンピュータが注目を浴びて自動化が進み、1970年代ではDECのPDP-11等のプロセス・コンピュータが大きく飛躍した。

それが1980年はオフィス領域に応用領域を広げ、その生産性をあげる期待から、オフコンが脚光をあびた。そして、遂にワードプロセッサーとしてタイプライタにとって替わることが見込まれ、空前の巨大市場が出現することが誰の目にも明らかとなった。

ワング、CPT等のワープロ専用ベンダ、IBMやバローズやゼロックス等の大型計算機や事務機の大手ベンダーはもちろん、レミントンやオリベッティやスミスコロナ等のタイプライタ業界、さらには巨大資本のエクソン等の石油業界やフォルクスワーゲンの自動車業界まで参入を目指した。

事務機器市場は、1960年頃からの電動のエレメント交換型のセレクトリック・タイプライタでビジネスを謳歌していたIBMを追って、電子化によってその規模は、250~400億ドルの市場になると推計された。

一方、パソコン業界となるマイコンもコモドールやアッププル1等もAO業界を目指した。

ソニーは、技術担当専務の岩間が、デジタル化へと舵を切った。そしてベータマックスから上がる特許ライセンス料をそこに投入した。また、トリニトロンも成長し続けていた。

そして、USのOA市場に参入することを決めた。そしてその先兵として、本社はもちろん、各工場や事業部もその思いに応えて動いた。

本社では、ソニーで計算機部長だった加藤善朗をシステム開発部を担当とした。

プロジェクト・マネジャとなってシステム開発部長となった加藤善朗が考えた3個のプロジェクトは、全て3種類のカセット型の外部メモリーから成るものであった。

その最上位機種は、いわばピクチャプロセッサーとでもいうべき大量の画像データを蓄積、加工・編集し検索できるシステムであったが、これには、記憶容量が多いなベータマックスのカセットが想定されていた。

また、最下位のタイプコーダは、井深に次いで社長となった盛田昭夫が、長年暖めてきたポータブル型のワードプロセッサーで、これが世界初のラップトップ型のマイコンの先駆けとなったが、そのリムーバブルメモリーは、1978年に世界規格となったマイクロカセット・テープであった。

また最も重要なプロジェクトは、シリーズ35という英文ワードプロセッサであった。

加藤は、OA用シリーズ35のキー・デバイスとして、3.5インチのMMFDの開発というサブプロジェクトを発足させ、そのきっかけを作った中山正之と佐藤隆二に小型のフロピーデスクの開発を担当させた。中山は、以前にも最上位機の画像データプロセッサーの基本技術を以前、Uマチックを使って実現させていた。

その発表を見たIBMがソニーから磁気記録に関する特許技術をソニーから導入し、8インチフロッピーデスクを開発していたが、それはメインフレーム用の80カラムの紙のカードを置き換えるものであった。

今度は、ソニー自体が、OAの本命であるシリーズ35と命名される英文ワードプロセッサーのコア・プロダクツの内蔵記憶デバイスと位置付けたのである。

ただ、コア・モジュールとしての3.5インチマイクロ・フロッピィデスクは、その親プロジェクトが、迷走を余儀なくされる結果となって行ったのであるが、すべてのワードプロセッサーに参入した企業にとって平たんではなかった。(これはプロローグでその故と物語りは紹介する予定である)

ソニーは、ハードは、ワードプロセサーの専門企業として注目されていたCPT社のフルページ・ディスプレイに注目した。それはA4やレターサイズの1ページの文書をフルに見ながら編集できるWIZWIGであったし、ソニーはディスプレイでも差を付けられる可能性を感じたからでもあった。そして、マン・マシンインターフェースとしての会話モードは、英語の自然言語体系を採用した。

IBMはディスプレイ・ライタとして、A4の上半分しか見ることができない12インチのハーフサイズ・ディスプレイを採用していた。

一方、ゼロックスは、SATARシステムとして、スチーブ・ジョブスも憧れたフルページでそれもビットマップ・ディスプレイで、アイコンとマウスが連動する画期的なシステムであった。

通信も高速なイサーネットで、びっくりしたが、それも1インチΦの鉛管を壁に沿って工事する代物で、ソニーは、全米にこうした販売設置ができるネットワークを構築することはできないと競争がただ事でないことを痛感した。

ただ幸か不幸か彼らも価格的に、市場参入を果たすこことをあきらめた。駆動目標が高すぎたのである。

ソニーは、インスト向けに、デクテーティング・マシンとして、テープレコーダを病院や新聞社等に細々と販売するB2Bの販売ネットワークを持っていた。

岩間は、300億円投資し、OAの販売ネットを買収しようと提案してくれた。血気盛んなシステム事業部を立ち上げようとしていた企画スタッフは、「大丈夫です。製品の力で販売網を開拓して行きます」と胸を張って見せた。

それも岩間が健在で居られたなら、可能性はあったかも知れないが、後悔は先に立たずであった。

しかし、親プロジェクトのコア・プロダクツが決まったことで、そのコアデバイスとしての3.5インチMFDのフォーム・フィット・ファンクションの概要は決まった。

このメディアに記録されたデータを郵送する場合を考えると、USの封筒に入るサイズから3.5インチが妥当となった。

従来の8インチや登場しつつあった厚紙のカバーでなく、カセット化すれば、郵送が可能になる。

円筒形の蝋管型のデクテーション・レコードを開発したエディソンですら、それを入れて切ってを貼って郵送するための厚紙の円筒を用意し、蝋管が痛まないよいうに内部に野生の兎の毛を貼り付け、蓋をして切ってを貼る位置まで印刷したサプライ・グッズを用意していたことは、井深や盛田も含め、企画スタッフもエディソンの博物館で勉強していたからである。

ただ、カセットをドライバーにどのように装着するか。昔のLPレコードは、上の蓋を持ち上げ、レコードを回転センタに合わせてセットし、そこに針を上から最初のトラックに静かに降ろすという手順である。

オープンテープレコーダもヒトが最初に磁気テープが上手く読取りヘッドに接触するように面倒を見なくてはいけない。これがカセットテープとなって、前面ローディングという設置法が可能になった。前面の入り口に差し込むだけで後は機械がそれを吸い込んでセットしてくれるのである。もちろんオーデオのラジカセやウオークマンなどでは、ガバット大きくワニ口が空いてしそこに設置して、ヒトがそのワニ口を閉じてあげる方式もあったが、ベータでもそうだが、上部にデスプレイがあるプロダクツでは、前面から挿入するプロダクツスタイルが自然である。

18インチのフルページ・ディスプレイの下に、2台のMFDを全面ローディング方式で装着できれば、簡単にコピーもできる。3.5インチは、それにもぴったりだった。

ただ、そうすると、MFDを吸い込んで、回転センタの上部から内部の磁気シートだけを落とす仕組みとなるとその分、高さが大きくなる。

回転させる駆動モータは、ウオークマンの扁平モータを使うにしても、直接回転軸は1本の方がよい。こうして、高さは1インチとなったが、幅がと奥行が3.5インチで高さが1インチでゴロっとした形からコードネームが”ゴロンタ”と親プロジェクト・リーダだった林義男によって命名された。

さて、記録容量をどの位にするか?もし、エディソンがデクテーティング・マシンのアプリケーションマニュワルに書いているように、ビジネスレターであれば、最低レターサイズで2枚分が記録できれば、良い。

タイプライタのノーマルピッチは、10文字/インチで、レターサイズもA4サイズも文字を書いて読む幅は、8インチであり、80文字/行が標準である。行送りも標準とすれば、4、000文字/ページで、これに文字を編集するアトリビュート・コードをその倍としても、8Kバイトが最低となる。

しかし、製品化では64KBから128KBが実現でき、やがて倍トラック密度で256Kバイトへ、また線密度を倍化し512KBへ、さらに両面となって2HDとして1,280Kバイト、 さらに倍の線密度となって2,560KBで2EDと呼ばれた。そして最後には、最高はその4倍まで進化したようである。

まさにMFDは、スジの良い駆動目標であった。つまり、周辺の技術の進化の成果を吸収し、成長し、コア・プロダクツカテゴリーを進化させ、アプリケーションの領域が広がって行ったのである。最初はテキストデータだけであったが、最後には、画像を記録できる容量となり、マビカ等のデジタル画像用も商品化され、デジタルカメラのさきがけとなった。

#2.小型化して記憶容量を上げる

当時主流であったIBMの8インチに対し、3.5インチと小型にしても、容量は大きい程良いことは判り切っている。

ベータではカセットがVHSに比べ一回り小さかったため、長時間競争に巻き込まれた結果、非常に苦戦を強いられる結果となっていたことは、すでに述べた。ベータが次から次に長時間化の技術を開発すれば、松下とビクターは特許のクロスライセンスで守られて、その技術を使い、大きい分だけ、長時間化ができた。このいわば盛田流のソフト・アライアンス戦略の欠点ではあった。

さてこの高密度記録問題をどう解決するか?

プロジェクト・リーダを中山から引く継いだ田中儀礼は、8インチと5.25インチのセンターの決め方が、薄いプラスチックに明けられた比較的大きな穴で決まっていることに注目した。

1度ヘッドがメディアの表面に記録した信号のトラックを、読み出すときは、当然ながらその上をなぞらなくては正しいデータを読みとることができない。

磁気シートを回転させる心棒に着脱する度に、薄いプラスチックのシートのセンターの孔は、擦られて擦り減って行くのではないか?

彼は、8インチフリッピ―を取り寄せ観察した。そこで気が付いたのは、擦り減るというより、やや疲れてワカメ状に撚れていたセンターの孔であった。このセンターの孔を金属にしたらどうか?そのためには、磁気シートの中央に金属の板を張り付ける以外にない。

また回転するモータの心棒の力をその金属のセンタの孔を4角にし、心棒も4角の棒にし、尖らせそこに落とし込んで固定すれば、回転も伝わるし、着脱の精度も、データの精度あがり、その信頼性も上がるだろう。

では、そのセンターの回転棒に落とし込んでそれをどのように固定するか? その芯金を鉄にして、下から磁石で引っ張たらどうか? でもそこで磁石を使ったら、データの記録再生にノイズを与えないか?等が心配された。しかしこれは、試作で問題とならないことが確認された。

また、メディアに、金属の芯金やシャッターを使うことには、磁気製品本部長の戸澤圭三郎から、ビジネスモデルとしての懸念が表明された。

確かに、最盛期には、年間30億枚を超えるメデジアの出荷が達成されていたので、金属を使わず3.3円でも安くできていれば、年間100億円のキャッシュインの増加があったであろう。

とはいえ、金属の芯金こそが、メディアとドライバーの互換性の公差を稼いだコア技術だったのである。

そして、容量を64Kから倍倍と32倍まで進化させたスジの良いコア技術だったのである。トリニトロンのAG、ベータのアジマス等と同様、まさに公差拡大という共通したコア技術であったのである。

#3.ヘッド圧着法と自動開閉シャッターの開発

さて、厚紙でなく、プラスチックケースに入れるとして、その中で、磁気シートがくるくる回っているとして、記録再生するためには、シートとヘッドを接触がなるべく確り密着させることが肝心である。

グルグル回っているシートにしたから丸いセラミックで固められたヘッドを押し上げたとき、シートの上から何かで抑える方が良い。

ただそうすると、カセットの上下にはヘッドをシートにあてる下の孔と抑えるための上の孔が必要となる。そうなると厚紙方式のようにまた、それをカバーする厚紙の入れ物が必要になってしまう。

それを避けるために、上に穴を開けず、上からプラスチックの板バネで下に磁気シートを押し付けることを思い着いた。

とはいえ、ヘッドを当てるために下には穴を開けざるを得ない。

では、その部分だけをカバーする薄い金属板で挟んだシャッターを造ったらどうかと言うことになった。それで、従来のフロピーデスクのような外側のエンベロープは、不要となり、カセット型が実現した。

ただ、話は前後するが、後にアップルのスチーブ・ジョブスが、これをマッキントッシュに使いたいと言ってきたとき、彼は、MFDの出し入れをMACの本体側がコントロールするべきだと主張した。ヒトが手でコントロールするとMACがびっくりするというわけである。

それが、前から挿入するとき自動で開き、それがPCであろうがヒトであろうが出すとき自動で締る仕組と進化した。ソフトコントロールの思想である。

#4. ハード・フォーマットとソフト・フォーマット

ヘッドの記録トラックを再生時のヘッドが正確になぞるための許容差を小さくできる芯金というコア技術は活気的であったが、その許容差をさらに減らせるための自動でトラックをなぞる制御の仕組を取り入れるべきかの判断が求められた。

この回路を採用すれば、トラック間密度を上げることができ、容量も増大できエラー率も軽減できる。ただそのためには、ICをお越すため2000万円位の投資が余計に必要となる。

加藤は、芯金の精度に掛けた。自働制御でなく、オープン制御としたのである。

次に問題となったのは、記録・読み出しの信号の転送速度であった。加藤は、8インチの信号処理用のICの採用を決めた。

一方、企画スタッフは、市場の動向を分析していた。確かにその時点では、8インチが圧倒的にシェアーをもっていたが、5.25インチが、PCを中心に急速に伸びると予測した。それをベースに、トラック当りのセクタの切り方は、5.25インチと同一のフォーマッティングしたメディアを基本とすべきと主張した。

こうして、ハードのコントローに係るハードフォーマットは8インチを引き継ぎ、ソフトホーマットは、5.25インチを引き継ぐこととなった。

技術の系譜は、優れた遺伝子を引継ぎで行くものである。

#5. プラスチックは平らな形のカセットに成形できない

カセットのような形状、カセット化しようというアイデアは、ソニーでは、オーデオのテープレコーダやビデオレコーダでも、みんなが考えてきた自然なコンセプトであった。

さて、ではその形状デザインはどうするべきかであった。

薄型にしたいという要求条件は、明らかであるが、例えば菓子の最中の皮を造ってその中に円盤型の薄い磁気記録シートを入れて回すとする。記録再生するヘッドをそれに接浴させなくてはならない。芯金を磁気シートに接着固定し、その芯金をモータにひっかけて回すとして、従来の厚紙型と違って、固いカセットにするとヘッドの反対側から押し付ける訳にはいかない。

それより何より、薄くて固いプラスチックをどのように、平たく成形できるかが、大問題となった。

それが金属であっても、薄くして平面状に加工することは極めて困難である。例えば、2001年にスチーブ・ジョブスが、初代 iPod 背面のステンレス鏡面仕上げにも驚きを持って迎えられたが、次はアルミニウムの切削加工した筐体を「高精度アルミニウムユニボディ」と呼び、初めて採用した MacBook では、一枚のアルミの厚板から削り出したと説明している。

それによって薄く軽量で強度のある筐体、構造材の60%削減、アルミリサイクルによる環境負荷低減などを実現したとして、従来であれば試作品でしか使えない製法を製品で使った勇気が評価されている。ただ、金属といえども、薄くプレスで平に成型することは不可能である。

これは、デザインのこだわりでもあるが、軽薄をねらった場合の合理的な帰結である。金属の塊から削りだす以外に方法は無いのである。

では、3.5MFDは、これをどのように解決したか。

まさに設計思想を逆転させたのである。

通常プラスチックは、加熱して熔かした樹脂を押出口(ダイ/ダイス)から押し出して、空気中や水中で冷却して固化させる押出法がコストが安く量産でき一般的である。

ただ冷めて固くなったプラスチックでも薄く成形すれば、ペコペコと柔らかくなって、菓子の最中の上下の空間の精度は全く保てなくなって磁気シートが自由に回転できるスペースを確保することは困難である。

磁気シートのセンターには、磁石でチャッキングする芯金が貼り付けてある。これを全面からドライバーに差し込んだとき、モータのスピンドルピンは、下がってMFDが入ってくるのを待っている。挿入が終わると、モータとスピンドルピンは持ち上げられて、磁石がMFDの芯金を吸いつけてチャッキングする。その時、カセットの上部の最中の皮を、押し上げたらどうか。

これは、メカ図面の評価で「メカ検」と呼ばれるとき、このプロジェクト・リーダであった、メカ屋で、メカ検の鬼といわれた松山政二の口癖であった。

「この設計思想は何か?」と何枚か問い詰められた時のチームが出した結論であった。

このスピンドルピンが、カセットの下部から2~3ミリ上までせり上がる構造が、MFDドライブのエッセンシャル特許の一つのコ技術となったのである。

#6.静電チャージエラー

磁気記録は、当然ながらアナログである。アナログの信号波形を回路で処理し、デジタルデータとして読み書きし、情報処理するのである。

当初その関係を理解するまで、戸惑いがあった。電気信号を電子回路で処理する途中で、誤差が入る。

例えばそこへ、静電チャージが起き、その放電もノイズとなるのである。当初そうした現象も判らなかった。

磁気シートが高速に回転し、セラミックで固められたヘッドが摩擦し、静電気をチャージし、それが放電するとき、ヘッドが信号と間違えてとして拾ってしまうのである。

そこで、ヘッドにチャージした電荷をシャーシに逃がす経路を設計した。だが、効果が挙がらなかった。

それをベータ版のデザイン・レビューした評価者が、その導線の抵抗値が高すぎることを指摘し、解決した。設計者は、シルバーペイントでディスチャージできると踏んでいたのである。

大学院を出たばかりのエンジニは、発生した静電がどのようであれ、アースへの回路に繋がっていれば良いと判断していたのである。実際には、静電の発生量とアース抵抗との差がやはりノイズの原因となっていたのである。

それよりなにより、デジタル回路では、アナログのようなエラーは足し算や引き算などのデジタル処理を起こさないのではないかというエンジニアさえ居たのである。

#7. デューティモードが判らない

3.5インチは、8インチや5.25インチに比べ、フリッピ―の着脱回数に対する信頼性に、絶対の自信を持っていた。

信頼性とは、与えられた環境で、期待される機能を、期待される時間において、発揮する確率と定義されている。

テレビは、1度点けるとなかなか切らない。結局テレビの信頼性は、単純にユーザが購入してからの経過時間や経過年数で評価することになる。

VTRも、これと似ていて、見始めると30分や1時間位は見続けるような、いわばユーザは、受け身で使うメディアである。

ソニーは、ベータマックスの失敗に学んで、岩間に続いて第4代の社長となった大賀典雄は、OEMベンダーの事業領域に進出することを、目指した。その最初が、3.5インチのMFDドライブであった。

親プロジェクトは、社長の岩間が就任間もなく亡くなり、新たに里親を探してソニーのデジタル化時代を構築しようとした岩間の構想は、ばらばらになった。

3.5インチMFDに最初に目を着けたのは、HPのD.ハックボーンだった。多分その年のコンピュータショウで、シリーズ35に搭載されていたのを見かけて、ソニーアメリカにコンタクトしたに違いない。

彼は、全てのエンジニアが憧れる電子計測器メーカの雄であったHPをOA元年にPCメーカを目指して舵を切ったのであった。

1982年にソニー厚木工場に現れたとき、プロジェクトリーダと企画スタッフは、陰ながら祝杯を挙げた。

このハックボーンこそ、3.5インチの育ての親となった人物と言ってよい。

かれは、アイアダホのじゃが芋畑から、買いに来たと、プロキュアメントとQAの担当者を左右に配して着席し、絶対に契約をまとめる決意を見せた。

QA担当が口を挟もうとしたとき、それを完全に制して、プロキュアメントの条項を細かく詰めた、3年分の買い付け計画と数か月分の調達枠の提示と3ヵ月の確定ローリング発注、またロットサイズ別の航空機の手配と、決済条件と円ドルの決済規準の月別計算法、不良品の扱い等等であった。

契約の体系はソニー側に任された。ソニーの法務部門は、この契約をOEM事業部のために完璧に支援した。一晩で、分厚い契約書がまとめられた。設計Gp.も本社の法務部からの電話に備え、厚木工場に泊まり込んだ。

大きな商談だった。そして、HPからは、信頼性は、ユーザの使い方で、そのヂューティモードを定義し、そのサイクル数で評価するべきことを教えられた。

3.5インチMFDを挿入し、それに記録再生を何回し、それを採りだすサイクルである。

また、HPの採用は、アップルのMACへの採用に繋がっていった。この頃になるとソニー本社のトップも、このプロジェクトに注意を向け始めた。事業部のトップ陣は、IBMへの売り込みを目指していたが、設計陣や企画スタッフは、IBMの別の官僚的な顔を見ていたので、最後になると予想していた。

そして、IBMの東側のエスタブリッシュ官僚達が、フロリダのヨットハーバ付の1ミリオンの別荘を毎週数人が購入しているとのOAディーラからの情報で、IBMのボカラトン工場が、乗っ取られたと喜んだ。これでIBM PCは絞殺されると予想したからであった。

まさにストーリはその通りとなり、IBMのPC ATコンパチ機の正当な流れは、コンパックに引き継がれて行ったのである。

そして、HPの会長と嘱望されていたハックボーンは、奥さまの意向を大切にされ、本社に行かずPCを育て、その後、そのコンパックも参加に納め、世界No.1のPCとプリンターベンダと成長する路線を引かれたのである。

プロキュアメントのプランの見事さは、半年の内示と3ヵ月ごとのローリング確定、そして航空機便の予約と運賃、円とドルの換算法、また数年のボリューム・プライス・スケジュールプランのツメは、契約条項の最後であったが、これは、ソニーの3.5インチのビジネス・マスタ・プランの骨格となった。それはまさに、トヨタのカンバン方式やソニーのセイバン管理方式を超える緻密で柔軟な方式であった。

その後、HPは、”インベントリー・ドリブン・コスト”という論文を発表した。ソニーのベータマックスも、トヨタのカルホルニア工場が生産していたピックアップトラックも、膨大な製品流通在庫で、莫大な被害を蒙ったのである。

この契約では、HPとの間でMFC条項:最恵国待遇を入れたが、その後来訪したアップルのスチーブ・ジョブスの契約の際に厳しい判断を迫られることにつながった。

とにかく、スチーブ・ジョブスは華やかに取沙汰されるが、PC業界には、もう一人の英雄が居たのである。

#8. 書込み防止窓、ヘッドパッドやヘッドクリーニング

記録したデータの上に再書き込みをすると、前のデータが消えてしまう。当初はフロピーの隅にペンで押すとそこが折れて外れるようにした。それをメカニカルにその有無を検出する方式とした。ただ、両面記録が実現すると、そのどちらを守るかが必要となる。

田中が考えたのは、ペンで突いて外れた細かいピースを、90度変えて元の孔に差し込むようにカセットのケースを成形できないか、と考えメカ部隊が実現した。

ただ、その後、ISO:世界規格への登録に際し、何らかの変更を求められ、オーバーライト防止にはメカ的なセンサーでなく光センサーに変更した。しかし、最初に考えたカセットの隅の□形の孔は、互換性が保たれるように使うことができた。

書込み防止のもう一つ挙げるとすれば、ヘッドパットと、ヘッドクリーニングパーツであろう。ヘッドを上から押し付けるのに、プラスチック製の板バネをリフターとして使うことは既に述べたが、当時登場した不織布を同時に接触させることで、ヘッドパッドの機能と同時に、ヘッドクリーニングの役割を持たせることができた。

#9 日本発の世界標準化

20世紀末から、ICTが世界の技術進化の中心となってきたが、その標準技術に貢献できた日本発の技術は、残念ながらあまりない。

その中で、3.5インチMFDは、数少ない一つと言える。それに寄与してくれたのは、HPであり、Apple であった。

しかし、日本発のホームパソコンのMSXの貢献は忘れてはならない。MSXは、マイクロソフトのビルゲーツとアスキーも西和彦が企画し、松下とソニーの頭文字を掛け算したMXSの意味であったようだ。

当時、日本では日立と松下が3インチのフローピー・デスクを開発しており、まさにベータとVHSのフォーマット争いの再現戦争の情況を呈していた。世界規格には、この国内状況が、影を落としていた。

ソニーでは、大賀がパソコンを井深さんが嫌っていたと思い込んでいたことから、反対であったが、後に役員となる出井伸之が、経営会議を押し切る形で、MSXプロジェクトを立ち上げた。

まさに、プロジェクトへの参加主体が、各社のプロジェクト主体で、金銭的な縛りではない絵に描いたようなソフト・アライアンスであった。

日本の電気メーカは、ベータ陣営であろうがVHS陣営であろうが全て、その他等12社位全てが参加した。

そのフォーマット確認の場が、ソニーで持たれた。アスキーの西とソニーのMSXの事業部長に盛田昌男が共同議長を務め、3.5インチか3インチのどちらを標準とするか、アゼンダの最後に取り上げられた。

西が口を開いた。「私は、どちらでも良いと思う。だた、単なるスタンダーゼーションでは無く、一つにした方が世界に市場が広がると思う。もし、MSXを世界規格にしたいなら、HPやアップルが採用した3.5が良いように思っているがどうぞご自由に」と発言して、右回りに順次発言者が3.5インチの支持発言が続いた。やがて日立が同調し、さいごに松下に回って、みんなが固唾をのんで見守った。青かったその顔が真っ赤になり「みなさんが相違仰るなら」と賛同した。これが、最後の決定の瞬間だった。

MSXは、世界標準として、中南米やスペインなどでは、最後まで根強く使われ、ヒトビトに愛されたホームPCだったが、ベータも中南米やスペインでは、同じように最後まで使われた。

3.5インチMFDのコア技術は、久夛良木健が開発した2インチのFDに引き継がれた。

そして、NDへ、CDへ、さらにCD-ROMへ、CD-Iへと進化し、デジタルマルチメディアの時代を切り拓いていった。

そして、デジタルのパッケージメディアが、デジタルのネットワークとして、インターネット時代の幕をあけることになる。

一方、ベータの普及で、プロ用の編集機として立ち上がったUマチックも、映像のデジタル化への道を拓いた。

最初はベータの色輝度分離のデジタル化であったが、RGB3色のコンポ―ネント方式を開発し、コンピュータとの相性を良くした。

これにより、ENG (Electronic News Gathering)が広く使われるようになり、生々しい戦争や事件の現場の映像が、茶の間に飛び込んでくるようになった。

これを担ったのは、ベータマックスとカメラが一体となってベータカムでそのテープのハードフォーマットは、デジタル時代の先頭をまだになっている。

こうしたICTの技術の流れは、最後のエピローグ編でまとめてみたい。さて、次章は、市場と向かいあうペネトレーション・フェーズとなる。

▼△▼△▼△▼△▼△▼△▼△▼△▼△▼△▼